+

+  @@ -1525,6 +1573,8 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

#### 分组查询

+分组查询会进行去重

+

* 分组查询语法

````mysql

@@ -1581,7 +1631,7 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

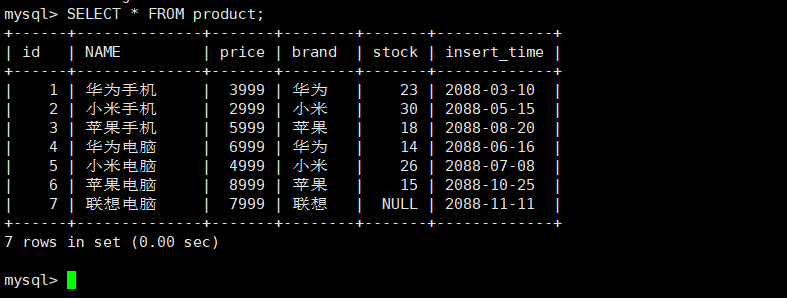

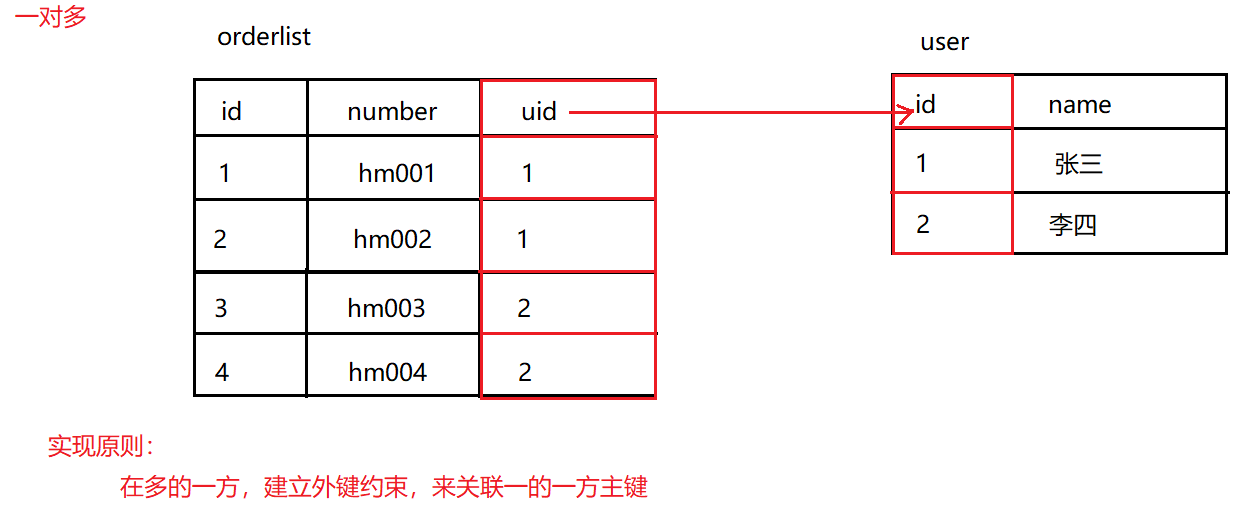

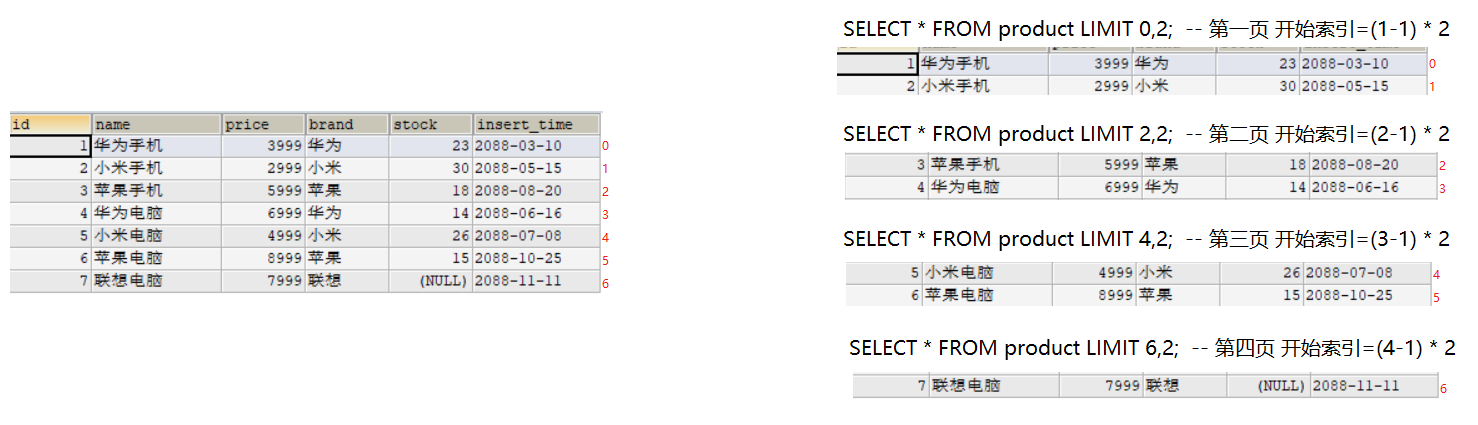

SELECT * FROM product LIMIT 6,2; -- 第四页 开始索引=(4-1) * 2

```

-

+

@@ -1594,11 +1644,13 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-## 约束操作

+## 多表操作

### 约束分类

-约束:对表中的数据进行限定,保证数据的正确性、有效性、完整性!

+#### 约束介绍

+

+约束:对表中的数据进行限定,保证数据的正确性、有效性、完整性

约束的分类:

@@ -1618,7 +1670,7 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-### 主键约束

+#### 主键约束

* 主键约束特点:

@@ -1670,9 +1722,9 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-### 主键自增

+#### 主键自增

-主键自增约束可以为空,并自动增长。删除某条数据不影响自增的下一个数值,依然按照前一个值自增。

+主键自增约束可以为空,并自动增长。删除某条数据不影响自增的下一个数值,依然按照前一个值自增

* 建表时添加主键自增约束

@@ -1716,7 +1768,7 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-### 唯一约束

+#### 唯一约束

唯一约束:约束不能有重复的数据

@@ -1748,7 +1800,7 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-### 非空约束

+#### 非空约束

* 建表时添加非空约束

@@ -1778,9 +1830,9 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-### 外键约束

+#### 外键约束

- 外键约束:让表和表之间产生关系,从而保证数据的准确性!

+ 外键约束:让表和表之间产生关系,从而保证数据的准确性

* 建表时添加外键约束

@@ -1833,9 +1885,14 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

DELETE FROM USER WHERE NAME='王五';

```

-

-### 外键级联

+

+

+***

+

+

+

+#### 外键级联

级联操作:当把主表中的数据进行删除或更新时,从表中有关联的数据的相应操作,包括 RESTRICT、CASCADE、SET NULL 和 NO ACTION

@@ -1875,16 +1932,12 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-## 多表操作

-

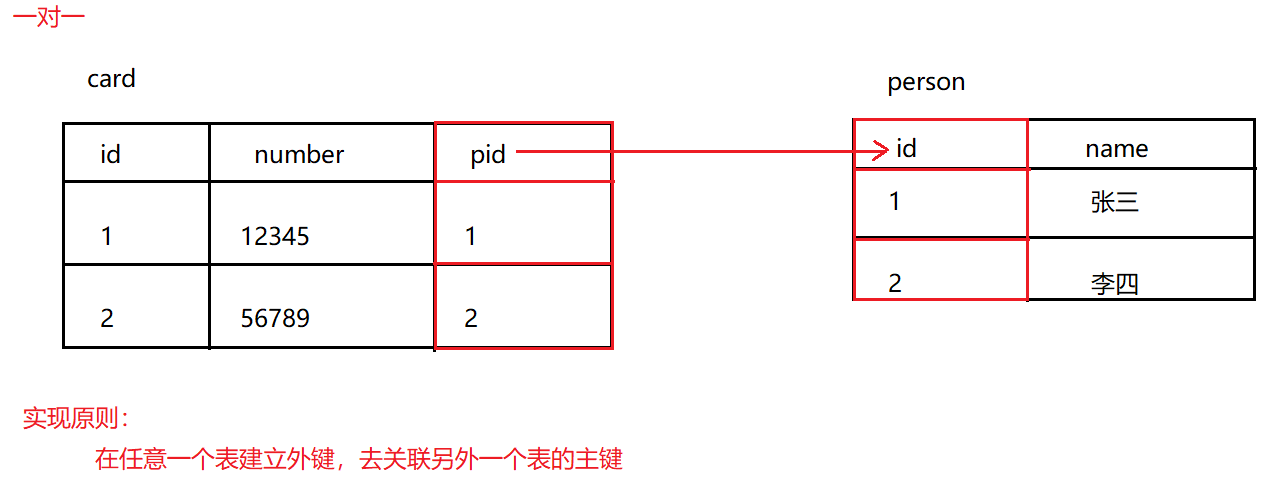

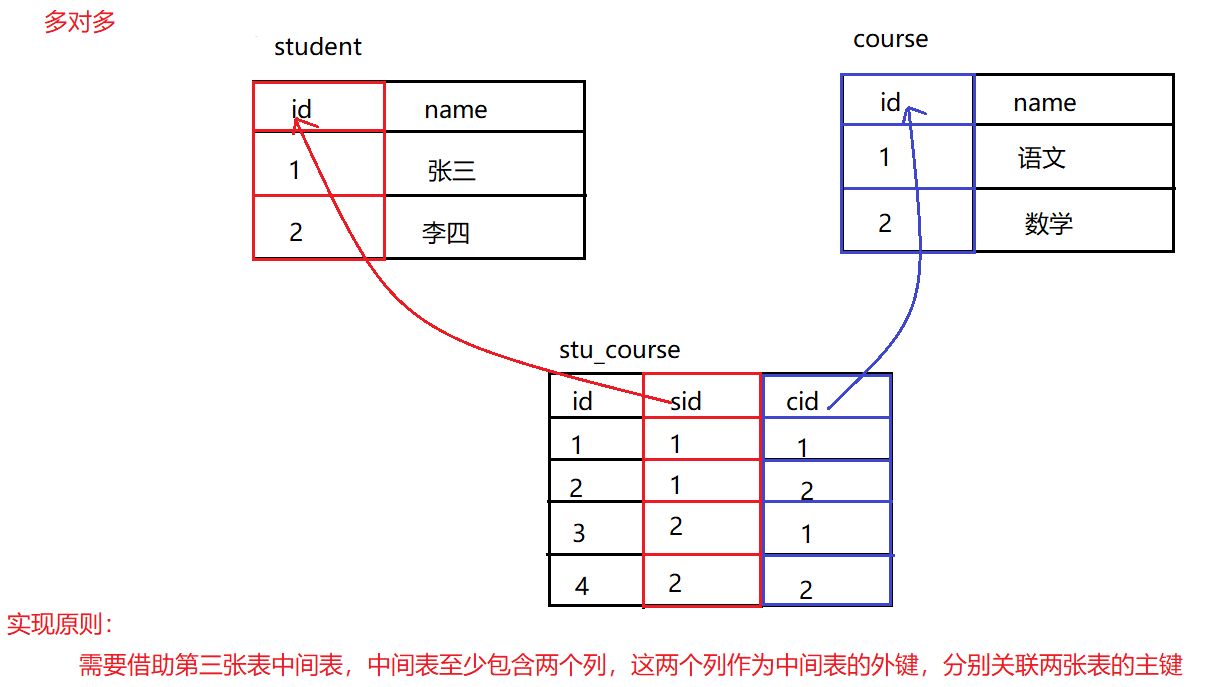

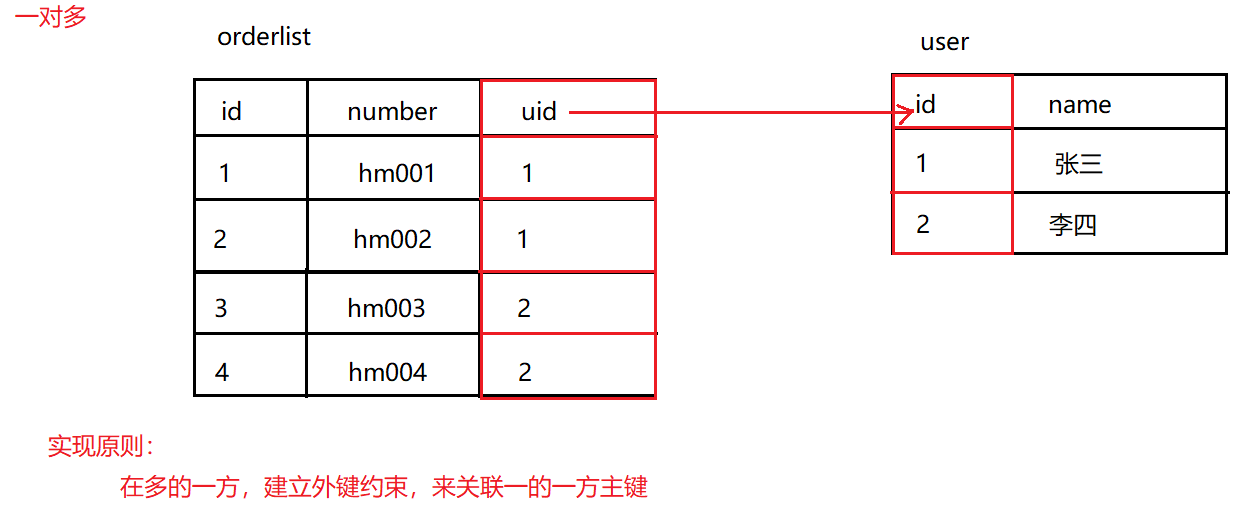

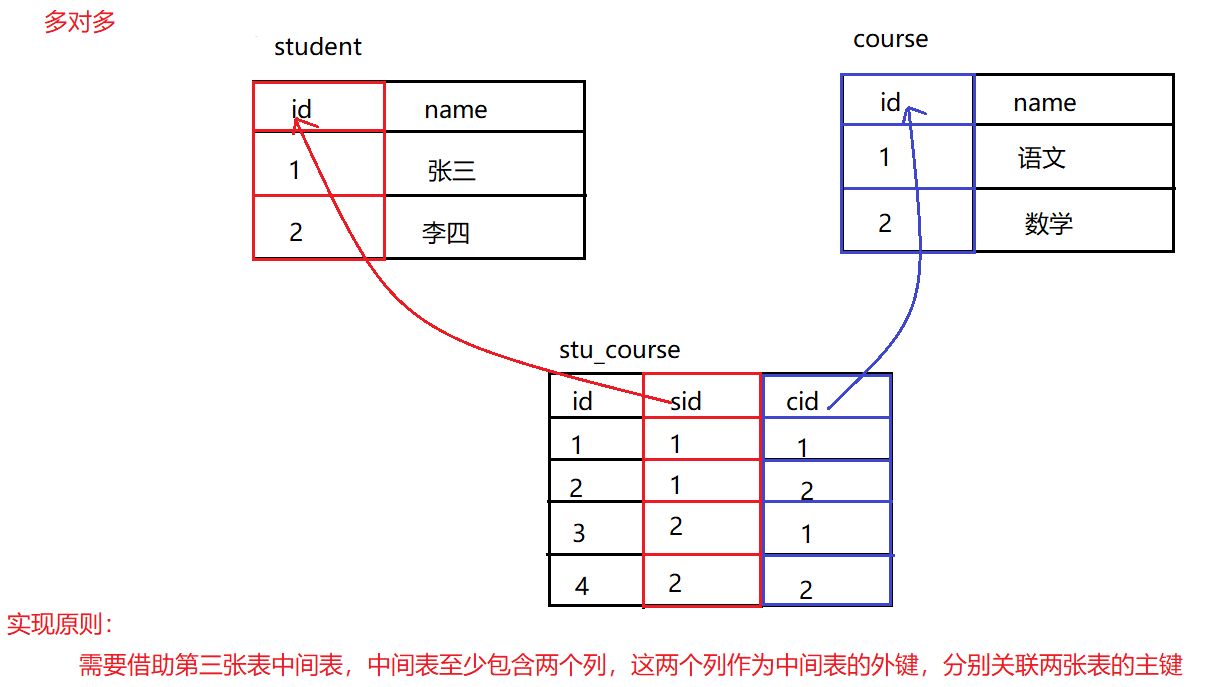

### 多表设计

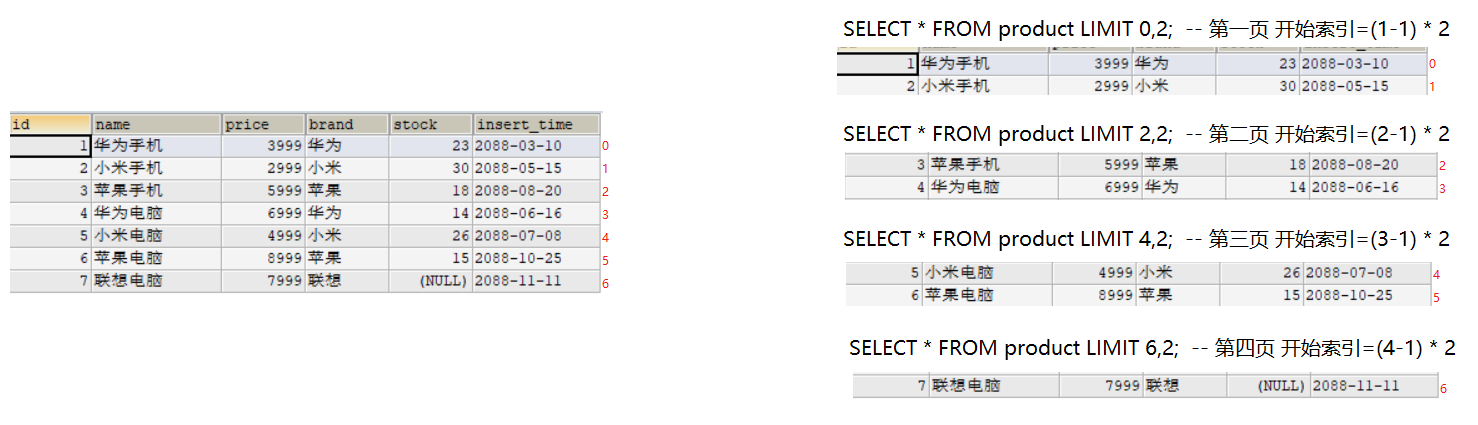

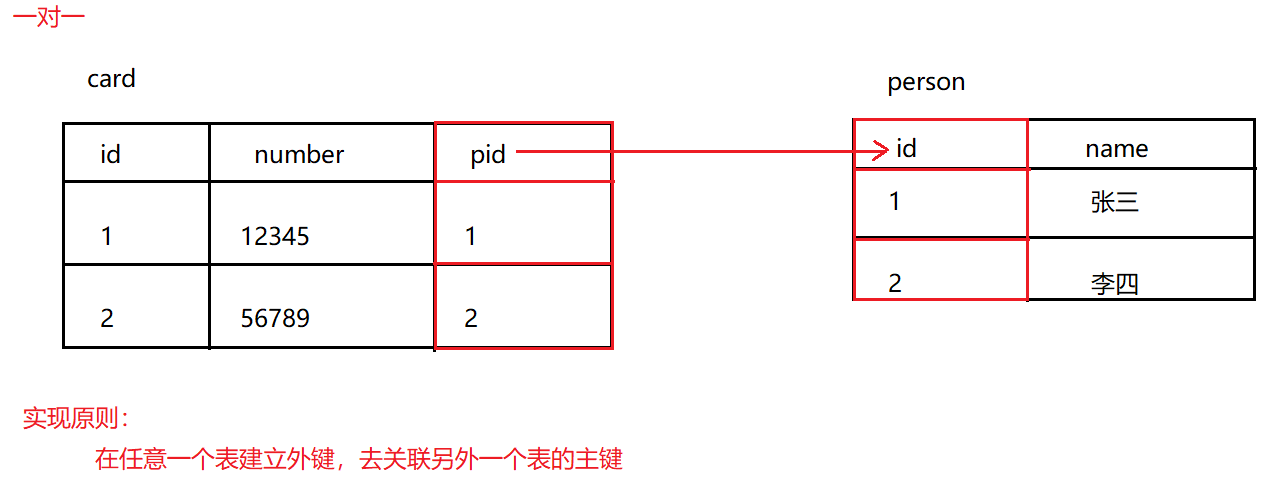

#### 一对一

多表:有多张数据表,而表与表之间有一定的关联关系,通过外键约束实现,分为一对一、一对多、多对多三类

-

-

举例:人和身份证

实现原则:在任意一个表建立外键,去关联另外一个表的主键

@@ -1909,7 +1962,11 @@ CREATE TABLE card(

INSERT INTO card VALUES (NULL,'12345',1),(NULL,'56789',2);

```

-

+

+

+

+

+***

@@ -1939,7 +1996,11 @@ CREATE TABLE orderlist(

INSERT INTO orderlist VALUES (NULL,'hm001',1),(NULL,'hm002',1),(NULL,'hm003',2),(NULL,'hm004',2);

```

-

+

+

+

+

+***

@@ -1978,7 +2039,7 @@ CREATE TABLE stu_course(

INSERT INTO stu_course VALUES (NULL,1,1),(NULL,1,2),(NULL,2,1),(NULL,2,2);

```

-

+

@@ -1986,50 +2047,30 @@ INSERT INTO stu_course VALUES (NULL,1,1),(NULL,1,2),(NULL,2,1),(NULL,2,2);

-### 多表查询

-

-#### 查询格式

-

-多表查询分类:

-

-* 内连接查询

-* 外连接查询

-* 子查询

-* 自关联查询

-

-多表查询格式:(笛卡儿积)

-

-```mysql

-SELECT

- 列名列表

-FROM

- 表名列表

-WHERE

- 条件...

-```

-

-

-

-***

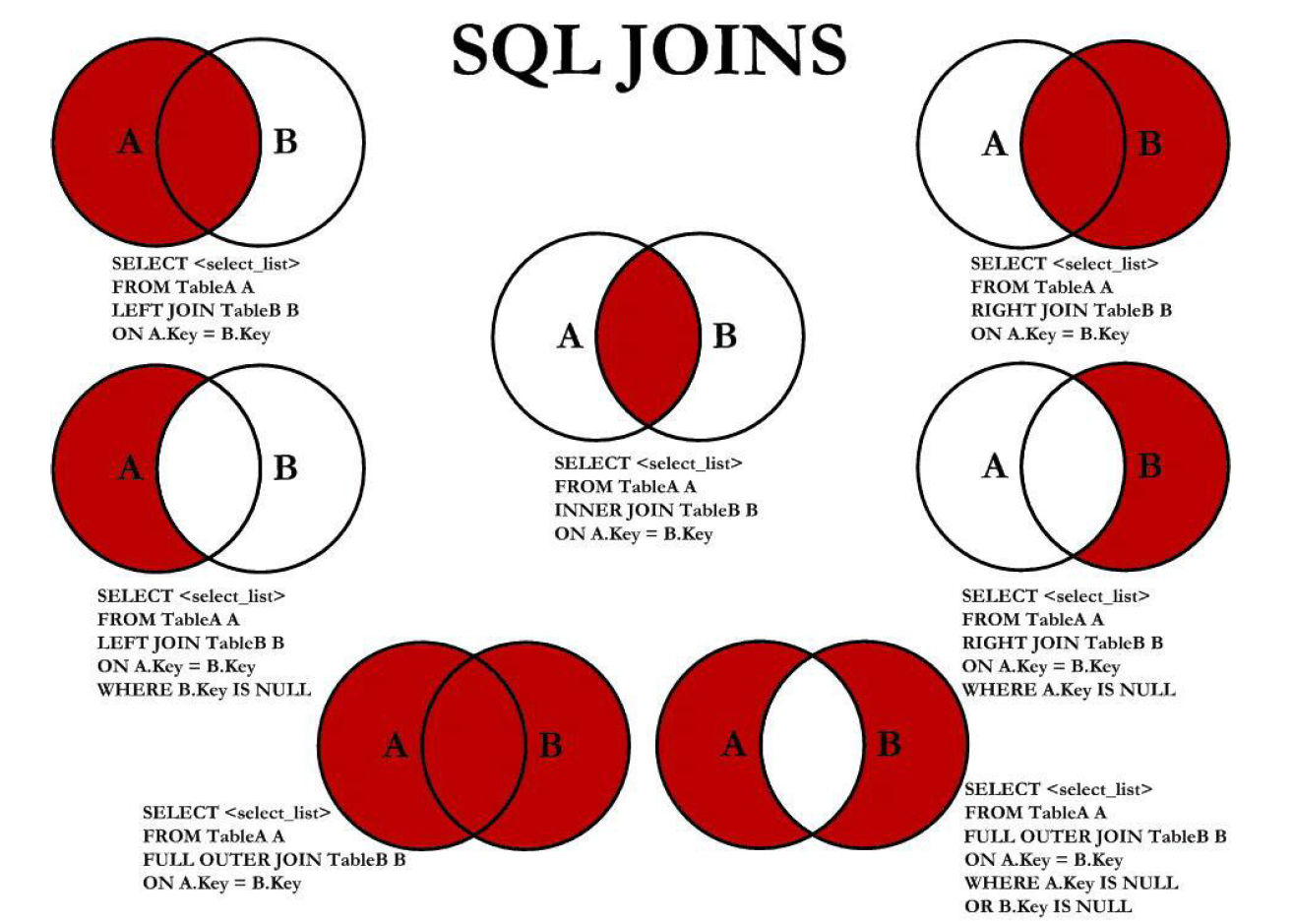

+### 连接查询

+#### 内外连接

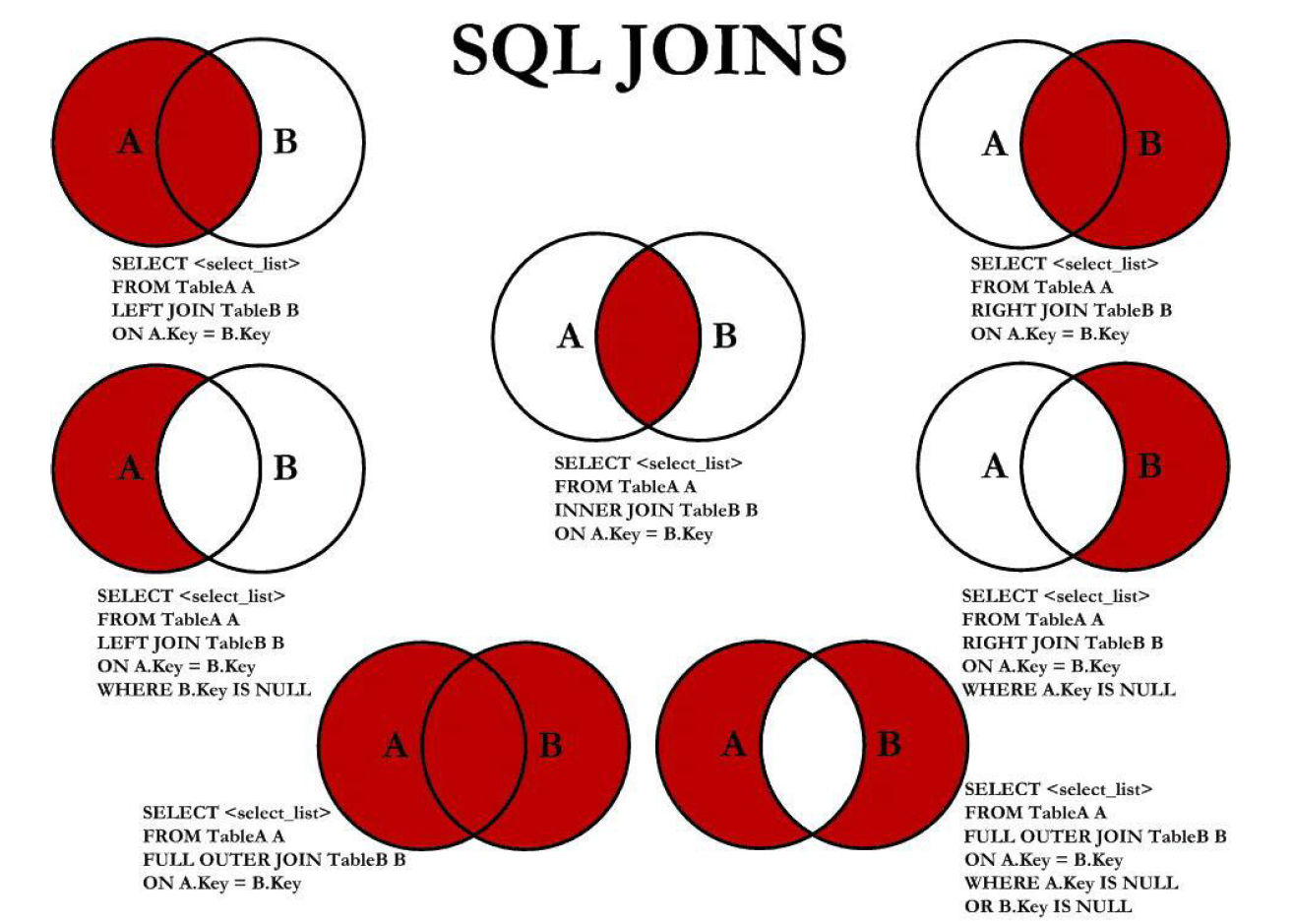

+##### 内连接

-#### 内连接

+连接查询的是两张表有交集的部分数据,两张表分为**驱动表和被驱动表**,如果结果集中的每条记录都是两个表相互匹配的组合,则称这样的结果集为笛卡尔积

-查询原理:内连接查询的是两张表有交集的部分数据,分为驱动表和被驱动表,首先查询驱动表得到结果集,然后根据结果集中的每一条记录都分别到被驱动表中查找匹配

+内连接查询,若驱动表中的记录在被驱动表中找不到匹配的记录时,则该记录不会加到最后的结果集

-* 显式内连接

+* 显式内连接:

```mysql

SELECT 列名 FROM 表名1 [INNER] JOIN 表名2 ON 条件;

```

-* 隐式内连接

+* 隐式内连接:内连接中 WHERE 子句和 ON 子句是等价的

```mysql

SELECT 列名 FROM 表名1,表名2 WHERE 条件;

```

+STRAIGHT_JOIN与 JOIN 类似,只不过左表始终在右表之前读取,只适用于内连接

+

@@ -2037,21 +2078,25 @@ WHERE

-#### 外连接

+##### 外连接

+

+外连接查询,若驱动表中的记录在被驱动表中找不到匹配的记录时,则该记录也会加到最后的结果集,只是对于被驱动表中**不匹配过滤条件**的记录,各个字段使用 NULL 填充

-* 左外连接:查询左表的全部数据,和左右两张表有交集部分的数据

+应用实例:查学生成绩,也想展示出缺考的人的成绩

+

+* 左外连接:选择左侧的表为驱动表,查询左表的全部数据,和左右两张表有交集部分的数据

```mysql

SELECT 列名 FROM 表名1 LEFT [OUTER] JOIN 表名2 ON 条件;

```

-* 右外连接:查询右表的全部数据,和左右两张表有交集部分的数据

+* 右外连接:选择右侧的表为驱动表,查询右表的全部数据,和左右两张表有交集部分的数据

```mysql

SELECT 列名 FROM 表名1 RIGHT [OUTER] JOIN 表名2 ON 条件;

```

-

+

@@ -2060,72 +2105,28 @@ WHERE

-#### 子查询

-子查询概念:查询语句中嵌套了查询语句,**将嵌套查询称为子查询**

-* 结果是单行单列:可以将查询的结果作为另一条语句的查询条件,使用运算符判断

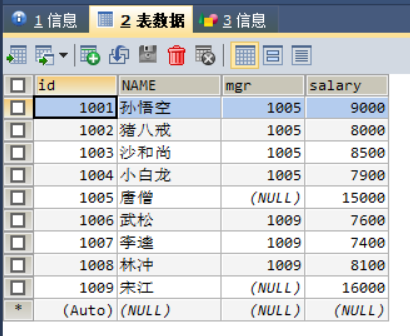

+#### 关联查询

- ```mysql

- SELECT 列名 FROM 表名 WHERE 列名=(SELECT 列名/聚合函数(列名) FROM 表名 [WHERE 条件]);

- ```

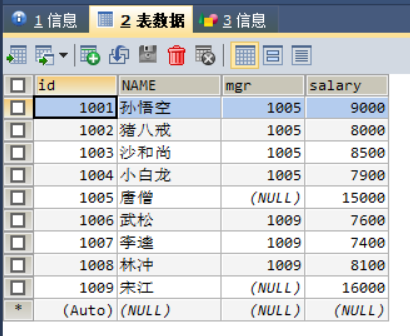

+自关联查询:同一张表中有数据关联,可以多次查询这同一个表

-* 结果是多行单列:可以作为条件,使用运算符in或not in进行判断

+* 数据准备

```mysql

- SELECT 列名 FROM 表名 WHERE 列名 [NOT] IN (SELECT 列名 FROM 表名 [WHERE 条件]);

+ -- 创建员工表

+ CREATE TABLE employee(

+ id INT PRIMARY KEY AUTO_INCREMENT, -- 员工编号

+ NAME VARCHAR(20), -- 员工姓名

+ mgr INT, -- 上级编号

+ salary DOUBLE -- 员工工资

+ );

+ -- 添加数据

+ INSERT INTO employee VALUES (1001,'孙悟空',1005,9000.00),..,(1009,'宋江',NULL,16000.00);

```

-

-* 结果是多行多列:查询的结果可以作为一张虚拟表参与查询

-

- ```mysql

- SELECT 列名 FROM 表名 [别名],(SELECT 列名 FROM 表名 [WHERE 条件]) [别名] [WHERE 条件];

- -- 查询订单表orderlist中id大于4的订单信息和所属用户USER信息

- SELECT

- *

- FROM

- USER u,

- (SELECT * FROM orderlist WHERE id>4) o

- WHERE

- u.id=o.uid;

- ```

-

-

-

-

-***

-

-

-

-#### 自关联

-

-自关联查询:同一张表中有数据关联,可以多次查询这同一个表

-

-* 数据准备

-

- ```mysql

- -- 创建员工表

- CREATE TABLE employee(

- id INT PRIMARY KEY AUTO_INCREMENT, -- 员工编号

- NAME VARCHAR(20), -- 员工姓名

- mgr INT, -- 上级编号

- salary DOUBLE -- 员工工资

- );

- -- 添加数据

- INSERT INTO employee VALUES (1001,'孙悟空',1005,9000.00),

- (1002,'猪八戒',1005,8000.00),

- (1003,'沙和尚',1005,8500.00),

- (1004,'小白龙',1005,7900.00),

- (1005,'唐僧',NULL,15000.00),

- (1006,'武松',1009,7600.00),

- (1007,'李逵',1009,7400.00),

- (1008,'林冲',1009,8100.00),

- (1009,'宋江',NULL,16000.00);

- ```

-

-

-

+

+

* 数据查询

```mysql

@@ -2165,15 +2166,208 @@ WHERE

1009 宋江 NULL NULL NULL

```

+

+

+***

+

+

+

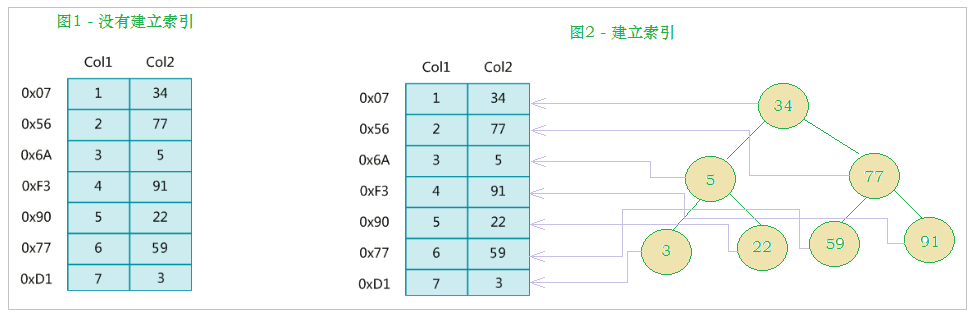

+#### 连接原理

+

+Index Nested-Loop Join 算法:查询驱动表得到**数据集**,然后根据数据集中的每一条记录的**关联字段再分别**到被驱动表中查找匹配(**走索引**),所以驱动表只需要访问一次,被驱动表要访问多次

+

+MySQL 将查询驱动表后得到的记录成为驱动表的扇出,连接查询的成本:单次访问驱动表的成本 + 扇出值 * 单次访问被驱动表的成本,优化器会选择成本最小的表连接顺序(确定谁是驱动表,谁是被驱动表)生成执行计划,进行连接查询,优化方式:

+

+* 减少驱动表的扇出(让数据量小的表来做驱动表)

+* 降低访问被驱动表的成本

+

+说明:STRAIGHT_JOIN 是查一条驱动表,然后根据关联字段去查被驱动表,要访问多次驱动表,所以需要优化为 INL 算法

+

+Block Nested-Loop Join 算法:一种**空间换时间**的优化方式,基于块的循环连接,执行连接查询前申请一块固定大小的内存作为连接缓冲区 Join Buffer,先把若干条驱动表中的扇出暂存在缓冲区,每一条被驱动表中的记录一次性的与 Buffer 中多条记录进行匹配(扫描全部数据,一条一条的匹配),因为是在内存中完成,所以速度快,并且降低了 I/O 成本

+

+Join Buffer 可以通过参数 `join_buffer_size` 进行配置,默认大小是 256 KB

+

+在成本分析时,对于很多张表的连接查询,连接顺序有非常多,MySQL 如果挨着进行遍历计算成本,会消耗很多资源

+

+* 提前结束某种连接顺序的成本评估:维护一个全局变量记录当前成本最小的连接方式,如果一种顺序只计算了一部分就已经超过了最小成本,可以提前结束计算

+* 系统变量 optimizer_search_depth:如果连接表的个数小于该变量,就继续穷举分析每一种连接数量,反之只对数量与 depth 值相同的表进行分析,该值越大成本分析的越精确

+

+* 系统变量 optimizer_prune_level:控制启发式规则的启用,这些规则就是根据以往经验指定的,不满足规则的连接顺序不分析成本

+

+

+

+***

+

+

+

+#### 连接优化

+

+##### BKA

+

+Batched Key Access 算法是对 NLJ 算法的优化,在读取被驱动表的记录时使用顺序 IO,Extra 信息中会有 Batched Key Access 信息

+

+使用 BKA 的表的 JOIN 过程如下:

+

+* 连接驱动表将满足条件的记录放入 Join Buffer,并将两表连接的字段放入一个 DYNAMIC_ARRAY ranges 中

+* 在进行表的过接过程中,会将 ranges 相关的信息传入 Buffer 中,进行被驱动表主建的查找及排序操作

+* 调用步骤 2 中产生的有序主建,**顺序读取被驱动表的数据**

+* 当缓冲区的数据被读完后,会重复进行步骤 2、3,直到记录被读取完

+

+使用 BKA 优化需要设进行设置:

+

+```mysql

+SET optimizer_switch='mrr=on,mrr_cost_based=off,batched_key_access=on';

+```

+

+说明:前两个参数的作用是启用 MRR,因为 BKA 算法的优化要依赖于 MRR(系统优化 → 内存优化 → Read 详解)

+

+

+

+***

+

+

+

+##### BNL

+

+###### 问题

+

+BNL 即 Block Nested-Loop Join 算法,由于要访问多次被驱动表,会产生两个问题:

+

+* Join 语句多次扫描一个冷表,并且语句执行时间小于 1 秒,就会在再次扫描冷表时,把冷表的数据页移到 LRU 链表头部,导致热数据被淘汰,影响业务的正常运行

+

+ 这种情况冷表的数据量要小于整个 Buffer Pool 的 old 区域,能够完全放入 old 区,才会再次被读时加到 young,否则读取下一段时就已经把上一段淘汰

+

+* Join 语句在循环读磁盘和淘汰内存页,进入 old 区域的数据页很可能在 1 秒之内就被淘汰,就会导致 MySQL 实例的 Buffer Pool 在这段时间内 young 区域的数据页没有被合理地淘汰

+

+大表 Join 操作虽然对 IO 有影响,但是在语句执行结束后对 IO 的影响随之结束。但是对 Buffer Pool 的影响就是持续性的,需要依靠后续的查询请求慢慢恢复内存命中率

+

+

+

+###### 优化

+

+将 BNL 算法转成 BKA 算法,优化方向:

+

+* 在被驱动表上建索引,这样就可以根据索引进行顺序 IO

+* 使用临时表,**在临时表上建立索引**,将被驱动表和临时表进行连接查询

+

+驱动表 t1,被驱动表 t2,使用临时表的工作流程:

+

+* 把表 t1 中满足条件的数据放在临时表 tmp_t 中

+* 给临时表 tmp_t 的关联字段加上索引,使用 BKA 算法

+* 让表 t2 和 tmp_t 做 Join 操作(临时表是被驱动表)

+

+补充:MySQL 8.0 支持 hash join,join_buffer 维护的不再是一个无序数组,而是一个哈希表,查询效率更高,执行效率比临时表更高

+

+

+

+

+

+

+***

+

+

+

+### 嵌套查询

+

+#### 查询分类

+

+查询语句中嵌套了查询语句,**将嵌套查询称为子查询**,FROM 子句后面的子查询的结果集称为派生表

+

+根据结果分类:

+

+* 结果是单行单列:可以将查询的结果作为另一条语句的查询条件,使用运算符判断

+

+ ```mysql

+ SELECT 列名 FROM 表名 WHERE 列名=(SELECT 列名/聚合函数(列名) FROM 表名 [WHERE 条件]);

+ ```

+

+* 结果是多行单列:可以作为条件,使用运算符 IN 或 NOT IN 进行判断

+

+ ```mysql

+ SELECT 列名 FROM 表名 WHERE 列名 [NOT] IN (SELECT 列名 FROM 表名 [WHERE 条件]);

+ ```

+

+* 结果是多行多列:查询的结果可以作为一张虚拟表参与查询

+

+ ```mysql

+ SELECT 列名 FROM 表名 [别名],(SELECT 列名 FROM 表名 [WHERE 条件]) [别名] [WHERE 条件];

+ -- 查询订单表orderlist中id大于4的订单信息和所属用户USER信息

+ SELECT

+ *

+ FROM

+ USER u,

+ (SELECT * FROM orderlist WHERE id>4) o

+ WHERE

+ u.id=o.uid;

+ ```

+

+相关性分类:

+

+* 不相关子查询:子查询不依赖外层查询的值,可以单独运行出结果

+* 相关子查询:子查询的执行需要依赖外层查询的值

+

+

+

+****

+

+

+

+#### 查询优化

+

+不相关子查询的结果集会被写入一个临时表,并且在写入时**去重**,该过程称为**物化**,存储结果集的临时表称为物化表

+

+系统变量 tmp_table_size 或者 max_heap_table_size 为表的最值

+

+* 小于系统变量时,内存中可以保存,会为建立**基于内存**的 MEMORY 存储引擎的临时表,并建立哈希索引

+* 大于任意一个系统变量时,物化表会使用**基于磁盘**的 InnoDB 存储引擎来保存结果集中的记录,索引类型为 B+ 树

+

+物化后,嵌套查询就相当于外层查询的表和物化表进行内连接查询,然后经过优化器选择成本最小的表连接顺序执行查询

+

+子查询物化会产生建立临时表的成本,但是将子查询转化为连接查询可以充分发挥优化器的作用,所以引入:半连接

+

+* t1 和 t2 表进行半连接,对于 t1 表中的某条记录,只需要关心在 t2 表中是否存在,而不需要关心有多少条记录与之匹配,最终结果集只保留 t1 的记录

+* 半连接只是执行子查询的一种方式,MySQL 并没有提供面向用户的半连接语法

+

+

+

+参考书籍:https://book.douban.com/subject/35231266/

+

+

***

-### 多表练习

+#### 联合查询

+

+UNION 是取这两个子查询结果的并集,并进行去重,同时进行默认规则的排序(union 是行加起来,join 是列加起来)

+

+UNION ALL 是对两个结果集进行并集操作不进行去重,不进行排序

+

+```mysql

+(select 1000 as f) union (select id from t1 order by id desc limit 2); #t1表中包含id 为 1-1000 的数据

+```

+

+语句的执行流程:

+

+* 创建一个内存临时表,这个临时表只有一个整型字段 f,并且 f 是主键字段

+* 执行第一个子查询,得到 1000 这个值,并存入临时表中

+* 执行第二个子查询,拿到第一行 id=1000,试图插入临时表中,但由于 1000 这个值已经存在于临时表了,违反了唯一性约束,所以插入失败,然后继续执行

+* 取到第二行 id=999,插入临时表成功

+* 从临时表中按行取出数据,返回结果并删除临时表,结果中包含两行数据分别是 1000 和 999

+

+

-#### 数据准备

+

+

+****

+

+

+

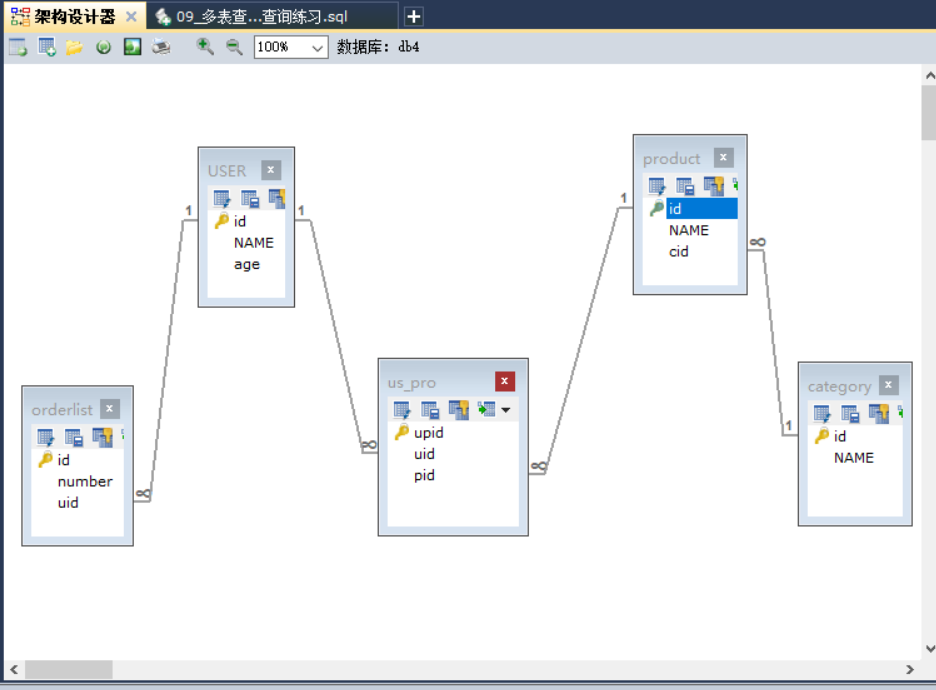

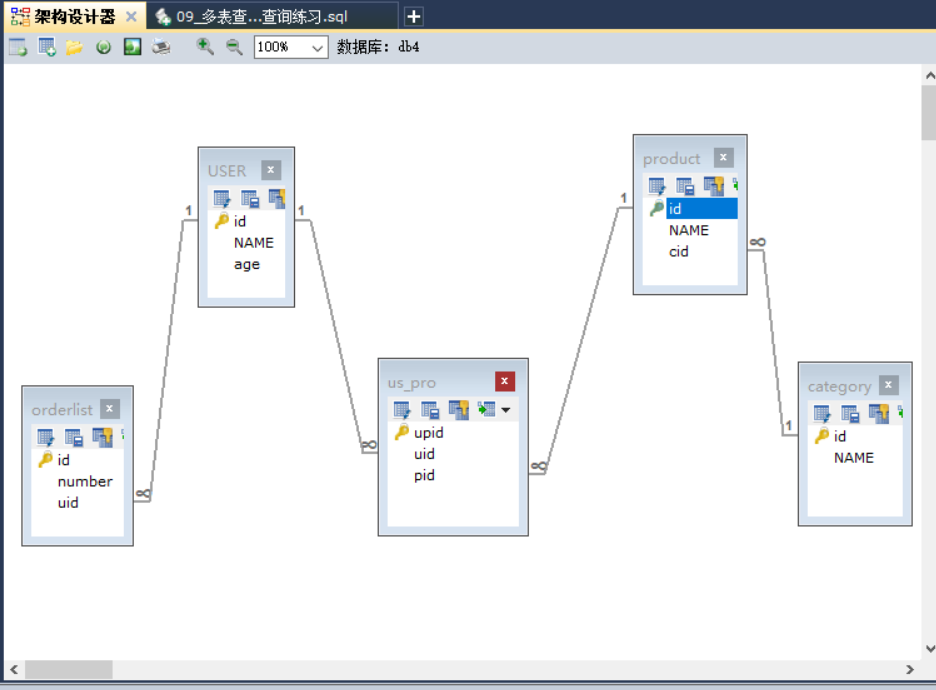

+### 查询练习

+

+数据准备:

```mysql

-- 创建db4数据库

@@ -2220,17 +2414,18 @@ CREATE TABLE us_pro(

);

```

-

+

-#### 数据查询

-

-1. 查询用户的编号、姓名、年龄、订单编号。

- 分析:

- 数据:用户的编号、姓名、年龄在user表,订单编号在orderlist表

- 条件:user.id = orderlist.uid

+**数据查询:**

+1. 查询用户的编号、姓名、年龄、订单编号

+

+ 数据:用户的编号、姓名、年龄在 user 表,订单编号在 orderlist 表

+

+ 条件:user.id = orderlist.uid

+

```mysql

SELECT

u.*,

@@ -2241,7 +2436,7 @@ CREATE TABLE us_pro(

WHERE

u.id = o.uid;

```

-

+

2. 查询所有的用户,显示用户的编号、姓名、年龄、订单编号。

```mysql

@@ -2256,7 +2451,7 @@ CREATE TABLE us_pro(

u.id = o.uid;

```

-3. 查询用户年龄大于 23 岁的信息,显示用户的编号、姓名、年龄、订单编号。

+3. 查询用户年龄大于 23 岁的信息,显示用户的编号、姓名、年龄、订单编号

```mysql

SELECT

@@ -2297,8 +2492,10 @@ CREATE TABLE us_pro(

u.name IN ('张三','李四');

````

-5. 查询所有的用户和该用户能查看的所有的商品,显示用户的编号、姓名、年龄、商品名称。

- 数据:用户的编号、姓名、年龄在user表,商品名称在product表,中间表 us_pro

+5. 查询所有的用户和该用户能查看的所有的商品,显示用户的编号、姓名、年龄、商品名称

+

+ 数据:用户的编号、姓名、年龄在 user 表,商品名称在 product 表,中间表 us_pro

+

条件:us_pro.uid = user.id AND us_pro.pid = product.id

```mysql

@@ -2343,190 +2540,198 @@ CREATE TABLE us_pro(

-****

-

-

-

-

+***

-## 事务机制

-### 事务介绍

-事务(Transaction)是访问和更新数据库的程序执行单元;事务中可能包含一个或多个 sql 语句,这些语句要么都执行,要么都不执行。作为一个关系型数据库,MySQL 支持事务。

-单元中的每条 SQL 语句都相互依赖,形成一个整体

-* 如果某条 SQL 语句执行失败或者出现错误,那么整个单元就会回滚,撤回到事务最初的状态

+## 高级结构

-* 如果单元中所有的 SQL 语句都执行成功,则事务就顺利执行

+### 视图

+#### 基本介绍

+视图概念:视图是一种虚拟存在的数据表,这个虚拟的表并不在数据库中实际存在

-***

+本质:将一条 SELECT 查询语句的结果封装到了一个虚拟表中,所以在创建视图的时候,工作重心要放在这条 SELECT 查询语句上

+作用:将一些比较复杂的查询语句的结果,封装到一个虚拟表中,再有相同查询需求时,直接查询该虚拟表

+优点:

-### 管理事务

+* 简单:使用视图的用户不需要关心表的结构、关联条件和筛选条件,因为虚拟表中已经是过滤好的结果集

+* 安全:使用视图的用户只能访问查询的结果集,对表的权限管理并不能限制到某个行某个列

-管理事务的三个步骤

+* 数据独立,一旦视图的结构确定,可以屏蔽表结构变化对用户的影响,源表增加列对视图没有影响;源表修改列名,则可以通过修改视图来解决,不会造成对访问者的影响

-1. 开启事务:记录回滚点,并通知服务器,将要执行一组操作,要么同时成功、要么同时失败

-2. 执行 SQL 语句:执行具体的一条或多条 SQL 语句

-3. 结束事务(提交|回滚)

+***

- - 提交:没出现问题,数据进行更新

- - 回滚:出现问题,数据恢复到开启事务时的状态

-事务操作:

+#### 视图创建

-* 开启事务

+* 创建视图

```mysql

- START TRANSACTION;

+ CREATE [OR REPLACE]

+ VIEW 视图名称 [(列名列表)]

+ AS 查询语句

+ [WITH [CASCADED | LOCAL] CHECK OPTION];

```

-* 回滚事务

+ `WITH [CASCADED | LOCAL] CHECK OPTION` 决定了是否允许更新数据使记录不再满足视图的条件:

- ```mysql

- ROLLBACK;

- ```

+ * LOCAL:只要满足本视图的条件就可以更新

+ * CASCADED:必须满足所有针对该视图的所有视图的条件才可以更新, 默认值

-* 提交事务,显示执行是手动提交,MySQL 默认为自动提交

+* 例如

```mysql

- COMMIT;

+ -- 数据准备 city

+ id NAME cid

+ 1 深圳 1

+ 2 上海 1

+ 3 纽约 2

+ 4 莫斯科 3

+

+ -- 数据准备 country

+ id NAME

+ 1 中国

+ 2 美国

+ 3 俄罗斯

+

+ -- 创建city_country视图,保存城市和国家的信息(使用指定列名)

+ CREATE

+ VIEW

+ city_country (city_id,city_name,country_name)

+ AS

+ SELECT

+ c1.id,

+ c1.name,

+ c2.name

+ FROM

+ city c1,

+ country c2

+ WHERE

+ c1.cid=c2.id;

```

- 工作原理:

+

- * 自动提交模式下,如果没有 start transaction 显式地开始一个事务,那么**每个 SQL 语句都会被当做一个事务执行提交操作**

- * 手动提交模式下,所有的 SQL 语句都在一个事务中,直到执行了 commit 或 rollback,该事务结束的同时开启另外一个事务

+***

- * 存在一些特殊的命令,在事务中执行了这些命令会马上强制执行 COMMIT 提交事务,如 DDL 语句 (create/drop/alter/table)、lock tables 语句等

- 提交方式语法:

- - 查看事务提交方式

+#### 视图查询

- ```mysql

- SELECT @@AUTOCOMMIT; -- 1 代表自动提交 0 代表手动提交

- ```

+* 查询所有数据表,视图也会查询出来

- - 修改事务提交方式

+ ```mysql

+ SHOW TABLES;

+ SHOW TABLE STATUS [\G];

+ ```

- ```mysql

- SET @@AUTOCOMMIT=数字; -- 系统

- SET AUTOCOMMIT=数字; -- 会话

- ```

-

- - 系统变量的操作:

-

- ```sql

- SET [GLOBAL|SESSION] 变量名 = 值; -- 默认是会话

- SET @@[(GLOBAL|SESSION).]变量名 = 值; -- 默认是系统

- ```

-

- ```sql

- SHOW [GLOBAL|SESSION] VARIABLES [LIKE '变量%']; -- 默认查看会话内系统变量值

- ```

+* 查询视图

-

+ ```mysql

+ SELECT * FROM 视图名称;

+ ```

-* 管理实务演示

+* 查询某个视图创建

```mysql

- -- 开启事务

- START TRANSACTION;

-

- -- 张三给李四转账500元

- -- 1.张三账户-500

- UPDATE account SET money=money-500 WHERE NAME='张三';

- -- 2.李四账户+500

- UPDATE account SET money=money+500 WHERE NAME='李四';

-

- -- 回滚事务(出现问题)

- ROLLBACK;

-

- -- 提交事务(没出现问题)

- COMMIT;

+ SHOW CREATE VIEW 视图名称;

```

-

-

***

-### 四大特征

-

-#### ACID

-

-事务的四大特征:ACID

-

-- 原子性 (atomicity)

-- 一致性 (consistency)

-- 隔离性 (isolaction)

-- 持久性 (durability)

+#### 视图修改

+视图表数据修改,会**自动修改源表中的数据**,因为更新的是视图中的基表中的数据

+* 修改视图表中的数据

-***

+ ```mysql

+ UPDATE 视图名称 SET 列名 = 值 WHERE 条件;

+ ```

+* 修改视图的结构

+ ```mysql

+ ALTER [ALGORITHM = {UNDEFINED | MERGE | TEMPTABLE}]

+ VIEW 视图名称 [(列名列表)]

+ AS 查询语句

+ [WITH [CASCADED | LOCAL] CHECK OPTION]

+

+ -- 将视图中的country_name修改为name

+ ALTER

+ VIEW

+ city_country (city_id,city_name,name)

+ AS

+ SELECT

+ c1.id,

+ c1.name,

+ c2.name

+ FROM

+ city c1,

+ country c2

+ WHERE

+ c1.cid=c2.id;

+ ```

-#### 原子性

-原子性是指事务是一个不可分割的工作单位,事务的操作如果成功就必须要完全应用到数据库,失败则不能对数据库有任何影响。比如事务中一个 SQL 语句执行失败,则已执行的语句也必须回滚,数据库退回到事务前的状态

-InnoDB 存储引擎提供了两种事务日志:redo log(重做日志)和 undo log(回滚日志)

+***

-* redo log 用于保证事务持久性

-* undo log 用于保证事务原子性和隔离性

-undo log 属于逻辑日志,根据每行操作进行记录,记录了 SQL 执行相关的信息,用来回滚行记录到某个版本

-当事务对数据库进行修改时,InnoDB 会先记录对应的 undo log,如果事务执行失败或调用了 rollback 导致事务回滚,InnoDB 会根据 undo log 的内容**做与之前相反的操作**:

+#### 视图删除

-* 对于每个 insert,回滚时会执行 delete

+* 删除视图

-* 对于每个 delete,回滚时会执行 insert

+ ```mysql

+ DROP VIEW 视图名称;

+ ```

-* 对于每个 update,回滚时会执行一个相反的 update,把数据修改回去

+* 如果存在则删除

-undo log 是采用段(segment)的方式来记录,每个 undo 操作在记录的时候占用一个 undo log segment

+ ```mysql

+ DROP VIEW IF EXISTS 视图名称;

+ ```

-rollback segment 称为回滚段,每个回滚段中有 1024 个 undo log segment

-* 在以前老版本,只支持 1 个 rollback segment,只能记录 1024 个 undo log segment

-* MySQL5.5 开始支持 128 个 rollback segment,支持 128*1024 个 undo 操作

-参考文章:https://www.cnblogs.com/kismetv/p/10331633.html

+***

-***

+### 存储过程

+#### 基本介绍

-#### 一致性

+存储过程和函数:存储过程和函数是事先经过编译并存储在数据库中的一段 SQL 语句的集合

-一致性是指事务执行前后,数据库的完整性约束没有被破坏,事务执行的前后都是合法的数据状态。

+存储过程和函数的好处:

-数据库的完整性约束包括但不限于:实体完整性(如行的主键存在且唯一)、列完整性(如字段的类型、大小、长度要符合要求)、外键约束、用户自定义完整性(如转账前后,两个账户余额的和应该不变)

+* 提高代码的复用性

+* 减少数据在数据库和应用服务器之间的传输,提高传输效率

+* 减少代码层面的业务处理

+* **一次编译永久有效**

-实现一致性的措施:

+存储过程和函数的区别:

-- 保证原子性、持久性和隔离性,如果这些特性无法保证,事务的一致性也无法保证

-- 数据库本身提供保障,例如不允许向整形列插入字符串值、字符串长度不能超过列的限制等

-- 应用层面进行保障,例如如果转账操作只扣除转账者的余额,而没有增加接收者的余额,无论数据库实现的多么完美,也无法保证状态的一致

+* 存储函数必须有返回值

+* 存储过程可以没有返回值

@@ -2534,80 +2739,138 @@ rollback segment 称为回滚段,每个回滚段中有 1024 个 undo log segme

-#### 隔离性

-

-隔离性是指,事务内部的操作与其他事务是隔离的,多个并发事务之间要相互隔离,不能互相干扰

+#### 基本操作

-* 严格的隔离性,对应了事务隔离级别中的 serializable,实际应用中对性能考虑很少使用可串行化

+DELIMITER:

-* 与原子性、持久性侧重于研究事务本身不同,隔离性研究的是**不同事务**之间的相互影响

+* DELIMITER 关键字用来声明 sql 语句的分隔符,告诉 MySQL 该段命令已经结束

-隔离性让并发情形下的事务之间互不干扰:

+* MySQL 语句默认的分隔符是分号,但是有时需要一条功能 sql 语句中包含分号,但是并不作为结束标识,这时使用 DELIMITER 来指定分隔符:

-- 一个事务的写操作对另一个事务的写操作(写写):锁机制保证隔离性

-- 一个事务的写操作对另一个事务的读操作(读写):MVCC 保证隔离性

+ ```mysql

+ DELIMITER 分隔符

+ ```

-锁机制:事务在修改数据之前,需要先获得相应的锁,获得锁之后,事务便可以修改数据;该事务操作期间,这部分数据是锁定的,其他事务如果需要修改数据,需要等待当前事务提交或回滚后释放锁(详解见锁机制)

+存储过程的创建调用查看和删除:

+* 创建存储过程

+ ```mysql

+ -- 修改分隔符为$

+ DELIMITER $

+

+ -- 标准语法

+ CREATE PROCEDURE 存储过程名称(参数...)

+ BEGIN

+ sql语句;

+ END$

+

+ -- 修改分隔符为分号

+ DELIMITER ;

+ ```

-***

+* 调用存储过程

+ ```mysql

+ CALL 存储过程名称(实际参数);

+ ```

+* 查看存储过程

-#### 持久性

+ ```mysql

+ SELECT * FROM mysql.proc WHERE db='数据库名称';

+ ```

-##### 实现原理

+* 删除存储过程

-持久性是指一个事务一旦被提交了,那么对数据库中数据的改变就是永久性的,接下来的其他操作或故障不应该对其有任何影响。

+ ```mysql

+ DROP PROCEDURE [IF EXISTS] 存储过程名称;

+ ```

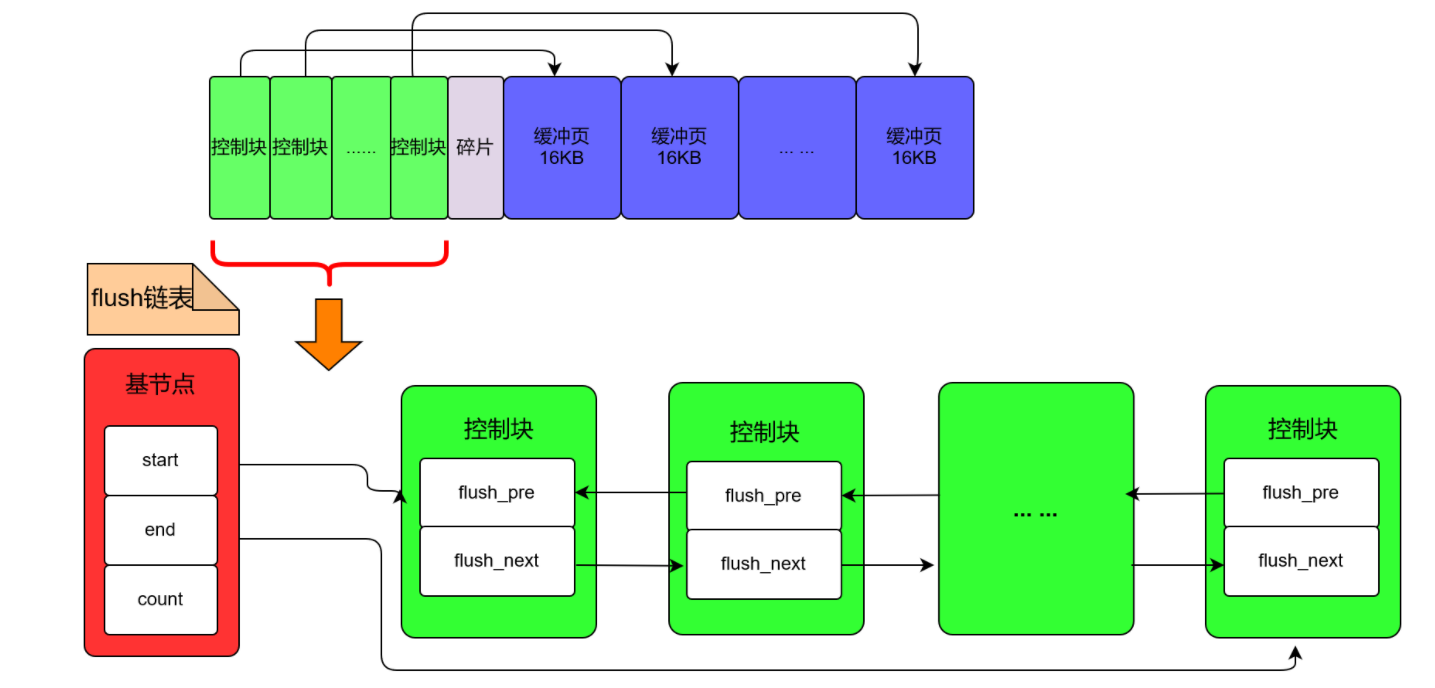

-Buffer Pool 是一片内存空间,可以通过 innodb_buffer_pool_size 来控制 Buffer Pool 的大小(内存优化部分会详解参数)

+练习:

-* Change Buffer 是 Buffer Pool 里的内存,不能无限增大,用来对增删改操作提供缓存

-* Change Buffer 的大小可以通过参数 innodb_change_buffer_max_size 来动态设置,设置为 50 时表示 Change Buffer 的大小最多只能占用 Buffer Pool 的 50%

-* 补充知识:**唯一索引的更新不能使用 Buffer**,一般只有普通索引可以使用,直接写入 Buffer 就结束

+* 数据准备

-InnoDB 的数据是按数据页为单位来读写,每个数据页的大小默认是 16KB。数据是存放在磁盘中,每次读写数据都需要磁盘 IO,效率会很低。InnoDB 提供了缓存 Change Buffer,Buffer 中包含了磁盘中部分数据页的映射,作为访问数据库的缓冲:

+ ```mysql

+ id NAME age gender score

+ 1 张三 23 男 95

+ 2 李四 24 男 98

+ 3 王五 25 女 100

+ 4 赵六 26 女 90

+ ```

-* 从数据库读取数据时,会首先从缓存中读取,如果缓存中没有,则从磁盘读取后放入 Buffer Pool

-* 向数据库写入数据时,会首先写入缓存,缓存中修改的数据会**定期刷新**到磁盘,这一过程称为刷脏

+* 创建 stu_group() 存储过程,封装分组查询总成绩,并按照总成绩升序排序的功能

+ ```mysql

+ DELIMITER $

+

+ CREATE PROCEDURE stu_group()

+ BEGIN

+ SELECT gender,SUM(score) getSum FROM student GROUP BY gender ORDER BY getSum ASC;

+ END$

+

+ DELIMITER ;

+

+ -- 调用存储过程

+ CALL stu_group();

+ -- 删除存储过程

+ DROP PROCEDURE IF EXISTS stu_group;

+ ```

+

***

-##### 数据恢复

-

-Buffer Pool 的使用提高了读写数据的效率,但是也带了新的问题:如果 MySQL 宕机,此时 Buffer Pool 中修改的数据还没有刷新到磁盘,就会导致数据的丢失,事务的持久性无法保证,所以引入 redo log

-

-* 当数据修改时,先修改 Change Buffer 中的数据,然后在 redo log buffer 记录这次操作

-* 如果 MySQL 宕机,InnoDB 判断一个数据页在崩溃恢复时丢失了更新,就会将它读到内存,然后根据 redo log 内容更新内存,更新完成后,内存页变成脏页,然后进行刷脏(buffer pool 的任务)

+#### 存储语法

-redo log **记录数据页的物理修改**,而不是某一行或某几行的修改,用来恢复提交后的物理数据页,且只能恢复到最后一次提交的位置

+##### 变量使用

-redo log 采用的是 WAL(Write-ahead logging,**预写式日志**),所有修改要先写入日志,再更新到磁盘,保证了数据不会因 MySQL 宕机而丢失,从而满足了持久性要求

+存储过程是可以进行编程的,意味着可以使用变量、表达式、条件控制语句等,来完成比较复杂的功能

-redo log 也需要在事务提交时将日志写入磁盘,但是比将内存中的 Buffer Pool 修改的数据写入磁盘的速度快:

+* 定义变量:DECLARE 定义的是局部变量,只能用在 BEGIN END 范围之内

+

+ ```mysql

+ DECLARE 变量名 数据类型 [DEFAULT 默认值];

+ ```

+

+* 变量的赋值

-* 刷脏是随机 IO,因为每次修改的数据位置随机,但写 redo log 是尾部追加操作,属于顺序 IO

-* 刷脏是以数据页(Page)为单位的,一个页上的一个小修改都要整页写入,而 redo log 中只包含真正需要写入的部分,减少无效 IO

+ ```mysql

+ SET 变量名 = 变量值;

+ SELECT 列名 INTO 变量名 FROM 表名 [WHERE 条件];

+ ```

-InnoDB 引擎会在适当的时候,把内存中 redo log buffer 持久化到磁盘,具体的刷盘策略:

+* 数据准备:表 student

-* 通过修改参数 `innodb_flush_log_at_trx_commit` 设置:

- * 0:表示当提交事务时,并不将缓冲区的 redo 日志写入磁盘,而是等待主线程每秒刷新一次

- * 1:在事务提交时将缓冲区的 redo 日志**同步写入**到磁盘,保证一定会写入成功

- * 2:在事务提交时将缓冲区的 redo 日志异步写入到磁盘,不能保证提交时肯定会写入,只是有这个动作

-* 如果写入 redo log buffer 的日志已经占据了 redo log buffer 总容量的一半了,此时就会刷入到磁盘文件,这时会影响执行效率,所以开发中应该**避免大事务**

+ ```mysql

+ id NAME age gender score

+ 1 张三 23 男 95

+ 2 李四 24 男 98

+ 3 王五 25 女 100

+ 4 赵六 26 女 90

+ ```

-刷脏策略:

+* 定义两个 int 变量,用于存储男女同学的总分数

-* redo log 文件是固定大小的,如果写满了就要擦除以前的记录,在擦除之前需要把旧记录更新到磁盘中的数据文件中

-* Buffer Pool 内存不足,需要淘汰部分数据页,如果淘汰的是脏页,就要先将脏页写到磁盘(大事务)

-* 系统空闲时,后台线程会自动进行刷脏

-* MySQL 正常关闭时,会把内存的脏页都 flush 到磁盘上

+ ```mysql

+ DELIMITER $

+ CREATE PROCEDURE pro_test3()

+ BEGIN

+ -- 定义两个变量

+ DECLARE men,women INT;

+ -- 查询男同学的总分数,为men赋值

+ SELECT SUM(score) INTO men FROM student WHERE gender='男';

+ -- 查询女同学的总分数,为women赋值

+ SELECT SUM(score) INTO women FROM student WHERE gender='女';

+ -- 使用变量

+ SELECT men,women;

+ END$

+ DELIMITER ;

+ -- 调用存储过程

+ CALL pro_test3();

+ ```

@@ -2615,186 +2878,414 @@ InnoDB 引擎会在适当的时候,把内存中 redo log buffer 持久化到

-##### 工作流程

-

-MySQL中还存在 binlog(二进制日志)也可以记录写操作并用于数据的恢复,**保证数据不丢失**,二者的区别是:

-

-* 作用不同:redo log 是用于 crash recovery (故障恢复),保证 MySQL 宕机也不会影响持久性;binlog 是用于 point-in-time recovery 的,保证服务器可以基于时间点恢复数据,此外 binlog 还用于主从复制

-

-* 层次不同:redo log 是 InnoDB 存储引擎实现的,而 binlog 是MySQL的服务器层实现的,同时支持 InnoDB 和其他存储引擎

-

-* 内容不同:redo log 是物理日志,内容基于磁盘的 Page;binlog 的内容是二进制的,根据 binlog_format 参数的不同,可能基于SQL 语句、基于数据本身或者二者的混合(日志部分详解)

-

-* 写入时机不同:binlog 在事务提交时一次写入;redo log 的写入时机相对多元

+##### IF语句

-两种日志在 update 更新数据的**作用时机**:

+* if 语句标准语法

-```sql

-update T set c=c+1 where ID=2;

-```

+ ```mysql

+ IF 判断条件1 THEN 执行的sql语句1;

+ [ELSEIF 判断条件2 THEN 执行的sql语句2;]

+ ...

+ [ELSE 执行的sql语句n;]

+ END IF;

+ ```

-

@@ -1525,6 +1573,8 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

#### 分组查询

+分组查询会进行去重

+

* 分组查询语法

````mysql

@@ -1581,7 +1631,7 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

SELECT * FROM product LIMIT 6,2; -- 第四页 开始索引=(4-1) * 2

```

-

+

@@ -1594,11 +1644,13 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-## 约束操作

+## 多表操作

### 约束分类

-约束:对表中的数据进行限定,保证数据的正确性、有效性、完整性!

+#### 约束介绍

+

+约束:对表中的数据进行限定,保证数据的正确性、有效性、完整性

约束的分类:

@@ -1618,7 +1670,7 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-### 主键约束

+#### 主键约束

* 主键约束特点:

@@ -1670,9 +1722,9 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-### 主键自增

+#### 主键自增

-主键自增约束可以为空,并自动增长。删除某条数据不影响自增的下一个数值,依然按照前一个值自增。

+主键自增约束可以为空,并自动增长。删除某条数据不影响自增的下一个数值,依然按照前一个值自增

* 建表时添加主键自增约束

@@ -1716,7 +1768,7 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-### 唯一约束

+#### 唯一约束

唯一约束:约束不能有重复的数据

@@ -1748,7 +1800,7 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-### 非空约束

+#### 非空约束

* 建表时添加非空约束

@@ -1778,9 +1830,9 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-### 外键约束

+#### 外键约束

- 外键约束:让表和表之间产生关系,从而保证数据的准确性!

+ 外键约束:让表和表之间产生关系,从而保证数据的准确性

* 建表时添加外键约束

@@ -1833,9 +1885,14 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

DELETE FROM USER WHERE NAME='王五';

```

-

-### 外键级联

+

+

+***

+

+

+

+#### 外键级联

级联操作:当把主表中的数据进行删除或更新时,从表中有关联的数据的相应操作,包括 RESTRICT、CASCADE、SET NULL 和 NO ACTION

@@ -1875,16 +1932,12 @@ SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

-## 多表操作

-

### 多表设计

#### 一对一

多表:有多张数据表,而表与表之间有一定的关联关系,通过外键约束实现,分为一对一、一对多、多对多三类

-

-

举例:人和身份证

实现原则:在任意一个表建立外键,去关联另外一个表的主键

@@ -1909,7 +1962,11 @@ CREATE TABLE card(

INSERT INTO card VALUES (NULL,'12345',1),(NULL,'56789',2);

```

-

+

+

+

+

+***

@@ -1939,7 +1996,11 @@ CREATE TABLE orderlist(

INSERT INTO orderlist VALUES (NULL,'hm001',1),(NULL,'hm002',1),(NULL,'hm003',2),(NULL,'hm004',2);

```

-

+

+

+

+

+***

@@ -1978,7 +2039,7 @@ CREATE TABLE stu_course(

INSERT INTO stu_course VALUES (NULL,1,1),(NULL,1,2),(NULL,2,1),(NULL,2,2);

```

-

+

@@ -1986,50 +2047,30 @@ INSERT INTO stu_course VALUES (NULL,1,1),(NULL,1,2),(NULL,2,1),(NULL,2,2);

-### 多表查询

-

-#### 查询格式

-

-多表查询分类:

-

-* 内连接查询

-* 外连接查询

-* 子查询

-* 自关联查询

-

-多表查询格式:(笛卡儿积)

-

-```mysql

-SELECT

- 列名列表

-FROM

- 表名列表

-WHERE

- 条件...

-```

-

-

-

-***

+### 连接查询

+#### 内外连接

+##### 内连接

-#### 内连接

+连接查询的是两张表有交集的部分数据,两张表分为**驱动表和被驱动表**,如果结果集中的每条记录都是两个表相互匹配的组合,则称这样的结果集为笛卡尔积

-查询原理:内连接查询的是两张表有交集的部分数据,分为驱动表和被驱动表,首先查询驱动表得到结果集,然后根据结果集中的每一条记录都分别到被驱动表中查找匹配

+内连接查询,若驱动表中的记录在被驱动表中找不到匹配的记录时,则该记录不会加到最后的结果集

-* 显式内连接

+* 显式内连接:

```mysql

SELECT 列名 FROM 表名1 [INNER] JOIN 表名2 ON 条件;

```

-* 隐式内连接

+* 隐式内连接:内连接中 WHERE 子句和 ON 子句是等价的

```mysql

SELECT 列名 FROM 表名1,表名2 WHERE 条件;

```

+STRAIGHT_JOIN与 JOIN 类似,只不过左表始终在右表之前读取,只适用于内连接

+

@@ -2037,21 +2078,25 @@ WHERE

-#### 外连接

+##### 外连接

+

+外连接查询,若驱动表中的记录在被驱动表中找不到匹配的记录时,则该记录也会加到最后的结果集,只是对于被驱动表中**不匹配过滤条件**的记录,各个字段使用 NULL 填充

-* 左外连接:查询左表的全部数据,和左右两张表有交集部分的数据

+应用实例:查学生成绩,也想展示出缺考的人的成绩

+

+* 左外连接:选择左侧的表为驱动表,查询左表的全部数据,和左右两张表有交集部分的数据

```mysql

SELECT 列名 FROM 表名1 LEFT [OUTER] JOIN 表名2 ON 条件;

```

-* 右外连接:查询右表的全部数据,和左右两张表有交集部分的数据

+* 右外连接:选择右侧的表为驱动表,查询右表的全部数据,和左右两张表有交集部分的数据

```mysql

SELECT 列名 FROM 表名1 RIGHT [OUTER] JOIN 表名2 ON 条件;

```

-

+

@@ -2060,72 +2105,28 @@ WHERE

-#### 子查询

-子查询概念:查询语句中嵌套了查询语句,**将嵌套查询称为子查询**

-* 结果是单行单列:可以将查询的结果作为另一条语句的查询条件,使用运算符判断

+#### 关联查询

- ```mysql

- SELECT 列名 FROM 表名 WHERE 列名=(SELECT 列名/聚合函数(列名) FROM 表名 [WHERE 条件]);

- ```

+自关联查询:同一张表中有数据关联,可以多次查询这同一个表

-* 结果是多行单列:可以作为条件,使用运算符in或not in进行判断

+* 数据准备

```mysql

- SELECT 列名 FROM 表名 WHERE 列名 [NOT] IN (SELECT 列名 FROM 表名 [WHERE 条件]);

+ -- 创建员工表

+ CREATE TABLE employee(

+ id INT PRIMARY KEY AUTO_INCREMENT, -- 员工编号

+ NAME VARCHAR(20), -- 员工姓名

+ mgr INT, -- 上级编号

+ salary DOUBLE -- 员工工资

+ );

+ -- 添加数据

+ INSERT INTO employee VALUES (1001,'孙悟空',1005,9000.00),..,(1009,'宋江',NULL,16000.00);

```

-

-* 结果是多行多列:查询的结果可以作为一张虚拟表参与查询

-

- ```mysql

- SELECT 列名 FROM 表名 [别名],(SELECT 列名 FROM 表名 [WHERE 条件]) [别名] [WHERE 条件];

- -- 查询订单表orderlist中id大于4的订单信息和所属用户USER信息

- SELECT

- *

- FROM

- USER u,

- (SELECT * FROM orderlist WHERE id>4) o

- WHERE

- u.id=o.uid;

- ```

-

-

-

-

-***

-

-

-

-#### 自关联

-

-自关联查询:同一张表中有数据关联,可以多次查询这同一个表

-

-* 数据准备

-

- ```mysql

- -- 创建员工表

- CREATE TABLE employee(

- id INT PRIMARY KEY AUTO_INCREMENT, -- 员工编号

- NAME VARCHAR(20), -- 员工姓名

- mgr INT, -- 上级编号

- salary DOUBLE -- 员工工资

- );

- -- 添加数据

- INSERT INTO employee VALUES (1001,'孙悟空',1005,9000.00),

- (1002,'猪八戒',1005,8000.00),

- (1003,'沙和尚',1005,8500.00),

- (1004,'小白龙',1005,7900.00),

- (1005,'唐僧',NULL,15000.00),

- (1006,'武松',1009,7600.00),

- (1007,'李逵',1009,7400.00),

- (1008,'林冲',1009,8100.00),

- (1009,'宋江',NULL,16000.00);

- ```

-

-

-

+

+

* 数据查询

```mysql

@@ -2165,15 +2166,208 @@ WHERE

1009 宋江 NULL NULL NULL

```

+

+

+***

+

+

+

+#### 连接原理

+

+Index Nested-Loop Join 算法:查询驱动表得到**数据集**,然后根据数据集中的每一条记录的**关联字段再分别**到被驱动表中查找匹配(**走索引**),所以驱动表只需要访问一次,被驱动表要访问多次

+

+MySQL 将查询驱动表后得到的记录成为驱动表的扇出,连接查询的成本:单次访问驱动表的成本 + 扇出值 * 单次访问被驱动表的成本,优化器会选择成本最小的表连接顺序(确定谁是驱动表,谁是被驱动表)生成执行计划,进行连接查询,优化方式:

+

+* 减少驱动表的扇出(让数据量小的表来做驱动表)

+* 降低访问被驱动表的成本

+

+说明:STRAIGHT_JOIN 是查一条驱动表,然后根据关联字段去查被驱动表,要访问多次驱动表,所以需要优化为 INL 算法

+

+Block Nested-Loop Join 算法:一种**空间换时间**的优化方式,基于块的循环连接,执行连接查询前申请一块固定大小的内存作为连接缓冲区 Join Buffer,先把若干条驱动表中的扇出暂存在缓冲区,每一条被驱动表中的记录一次性的与 Buffer 中多条记录进行匹配(扫描全部数据,一条一条的匹配),因为是在内存中完成,所以速度快,并且降低了 I/O 成本

+

+Join Buffer 可以通过参数 `join_buffer_size` 进行配置,默认大小是 256 KB

+

+在成本分析时,对于很多张表的连接查询,连接顺序有非常多,MySQL 如果挨着进行遍历计算成本,会消耗很多资源

+

+* 提前结束某种连接顺序的成本评估:维护一个全局变量记录当前成本最小的连接方式,如果一种顺序只计算了一部分就已经超过了最小成本,可以提前结束计算

+* 系统变量 optimizer_search_depth:如果连接表的个数小于该变量,就继续穷举分析每一种连接数量,反之只对数量与 depth 值相同的表进行分析,该值越大成本分析的越精确

+

+* 系统变量 optimizer_prune_level:控制启发式规则的启用,这些规则就是根据以往经验指定的,不满足规则的连接顺序不分析成本

+

+

+

+***

+

+

+

+#### 连接优化

+

+##### BKA

+

+Batched Key Access 算法是对 NLJ 算法的优化,在读取被驱动表的记录时使用顺序 IO,Extra 信息中会有 Batched Key Access 信息

+

+使用 BKA 的表的 JOIN 过程如下:

+

+* 连接驱动表将满足条件的记录放入 Join Buffer,并将两表连接的字段放入一个 DYNAMIC_ARRAY ranges 中

+* 在进行表的过接过程中,会将 ranges 相关的信息传入 Buffer 中,进行被驱动表主建的查找及排序操作

+* 调用步骤 2 中产生的有序主建,**顺序读取被驱动表的数据**

+* 当缓冲区的数据被读完后,会重复进行步骤 2、3,直到记录被读取完

+

+使用 BKA 优化需要设进行设置:

+

+```mysql

+SET optimizer_switch='mrr=on,mrr_cost_based=off,batched_key_access=on';

+```

+

+说明:前两个参数的作用是启用 MRR,因为 BKA 算法的优化要依赖于 MRR(系统优化 → 内存优化 → Read 详解)

+

+

+

+***

+

+

+

+##### BNL

+

+###### 问题

+

+BNL 即 Block Nested-Loop Join 算法,由于要访问多次被驱动表,会产生两个问题:

+

+* Join 语句多次扫描一个冷表,并且语句执行时间小于 1 秒,就会在再次扫描冷表时,把冷表的数据页移到 LRU 链表头部,导致热数据被淘汰,影响业务的正常运行

+

+ 这种情况冷表的数据量要小于整个 Buffer Pool 的 old 区域,能够完全放入 old 区,才会再次被读时加到 young,否则读取下一段时就已经把上一段淘汰

+

+* Join 语句在循环读磁盘和淘汰内存页,进入 old 区域的数据页很可能在 1 秒之内就被淘汰,就会导致 MySQL 实例的 Buffer Pool 在这段时间内 young 区域的数据页没有被合理地淘汰

+

+大表 Join 操作虽然对 IO 有影响,但是在语句执行结束后对 IO 的影响随之结束。但是对 Buffer Pool 的影响就是持续性的,需要依靠后续的查询请求慢慢恢复内存命中率

+

+

+

+###### 优化

+

+将 BNL 算法转成 BKA 算法,优化方向:

+

+* 在被驱动表上建索引,这样就可以根据索引进行顺序 IO

+* 使用临时表,**在临时表上建立索引**,将被驱动表和临时表进行连接查询

+

+驱动表 t1,被驱动表 t2,使用临时表的工作流程:

+

+* 把表 t1 中满足条件的数据放在临时表 tmp_t 中

+* 给临时表 tmp_t 的关联字段加上索引,使用 BKA 算法

+* 让表 t2 和 tmp_t 做 Join 操作(临时表是被驱动表)

+

+补充:MySQL 8.0 支持 hash join,join_buffer 维护的不再是一个无序数组,而是一个哈希表,查询效率更高,执行效率比临时表更高

+

+

+

+

+

+

+***

+

+

+

+### 嵌套查询

+

+#### 查询分类

+

+查询语句中嵌套了查询语句,**将嵌套查询称为子查询**,FROM 子句后面的子查询的结果集称为派生表

+

+根据结果分类:

+

+* 结果是单行单列:可以将查询的结果作为另一条语句的查询条件,使用运算符判断

+

+ ```mysql

+ SELECT 列名 FROM 表名 WHERE 列名=(SELECT 列名/聚合函数(列名) FROM 表名 [WHERE 条件]);

+ ```

+

+* 结果是多行单列:可以作为条件,使用运算符 IN 或 NOT IN 进行判断

+

+ ```mysql

+ SELECT 列名 FROM 表名 WHERE 列名 [NOT] IN (SELECT 列名 FROM 表名 [WHERE 条件]);

+ ```

+

+* 结果是多行多列:查询的结果可以作为一张虚拟表参与查询

+

+ ```mysql

+ SELECT 列名 FROM 表名 [别名],(SELECT 列名 FROM 表名 [WHERE 条件]) [别名] [WHERE 条件];

+ -- 查询订单表orderlist中id大于4的订单信息和所属用户USER信息

+ SELECT

+ *

+ FROM

+ USER u,

+ (SELECT * FROM orderlist WHERE id>4) o

+ WHERE

+ u.id=o.uid;

+ ```

+

+相关性分类:

+

+* 不相关子查询:子查询不依赖外层查询的值,可以单独运行出结果

+* 相关子查询:子查询的执行需要依赖外层查询的值

+

+

+

+****

+

+

+

+#### 查询优化

+

+不相关子查询的结果集会被写入一个临时表,并且在写入时**去重**,该过程称为**物化**,存储结果集的临时表称为物化表

+

+系统变量 tmp_table_size 或者 max_heap_table_size 为表的最值

+

+* 小于系统变量时,内存中可以保存,会为建立**基于内存**的 MEMORY 存储引擎的临时表,并建立哈希索引

+* 大于任意一个系统变量时,物化表会使用**基于磁盘**的 InnoDB 存储引擎来保存结果集中的记录,索引类型为 B+ 树

+

+物化后,嵌套查询就相当于外层查询的表和物化表进行内连接查询,然后经过优化器选择成本最小的表连接顺序执行查询

+

+子查询物化会产生建立临时表的成本,但是将子查询转化为连接查询可以充分发挥优化器的作用,所以引入:半连接

+

+* t1 和 t2 表进行半连接,对于 t1 表中的某条记录,只需要关心在 t2 表中是否存在,而不需要关心有多少条记录与之匹配,最终结果集只保留 t1 的记录

+* 半连接只是执行子查询的一种方式,MySQL 并没有提供面向用户的半连接语法

+

+

+

+参考书籍:https://book.douban.com/subject/35231266/

+

+

***

-### 多表练习

+#### 联合查询

+

+UNION 是取这两个子查询结果的并集,并进行去重,同时进行默认规则的排序(union 是行加起来,join 是列加起来)

+

+UNION ALL 是对两个结果集进行并集操作不进行去重,不进行排序

+

+```mysql

+(select 1000 as f) union (select id from t1 order by id desc limit 2); #t1表中包含id 为 1-1000 的数据

+```

+

+语句的执行流程:

+

+* 创建一个内存临时表,这个临时表只有一个整型字段 f,并且 f 是主键字段

+* 执行第一个子查询,得到 1000 这个值,并存入临时表中

+* 执行第二个子查询,拿到第一行 id=1000,试图插入临时表中,但由于 1000 这个值已经存在于临时表了,违反了唯一性约束,所以插入失败,然后继续执行

+* 取到第二行 id=999,插入临时表成功

+* 从临时表中按行取出数据,返回结果并删除临时表,结果中包含两行数据分别是 1000 和 999

+

+

-#### 数据准备

+

+

+****

+

+

+

+### 查询练习

+

+数据准备:

```mysql

-- 创建db4数据库

@@ -2220,17 +2414,18 @@ CREATE TABLE us_pro(

);

```

-

+

-#### 数据查询

-

-1. 查询用户的编号、姓名、年龄、订单编号。

- 分析:

- 数据:用户的编号、姓名、年龄在user表,订单编号在orderlist表

- 条件:user.id = orderlist.uid

+**数据查询:**

+1. 查询用户的编号、姓名、年龄、订单编号

+

+ 数据:用户的编号、姓名、年龄在 user 表,订单编号在 orderlist 表

+

+ 条件:user.id = orderlist.uid

+

```mysql

SELECT

u.*,

@@ -2241,7 +2436,7 @@ CREATE TABLE us_pro(

WHERE

u.id = o.uid;

```

-

+

2. 查询所有的用户,显示用户的编号、姓名、年龄、订单编号。

```mysql

@@ -2256,7 +2451,7 @@ CREATE TABLE us_pro(

u.id = o.uid;

```

-3. 查询用户年龄大于 23 岁的信息,显示用户的编号、姓名、年龄、订单编号。

+3. 查询用户年龄大于 23 岁的信息,显示用户的编号、姓名、年龄、订单编号

```mysql

SELECT

@@ -2297,8 +2492,10 @@ CREATE TABLE us_pro(

u.name IN ('张三','李四');

````

-5. 查询所有的用户和该用户能查看的所有的商品,显示用户的编号、姓名、年龄、商品名称。

- 数据:用户的编号、姓名、年龄在user表,商品名称在product表,中间表 us_pro

+5. 查询所有的用户和该用户能查看的所有的商品,显示用户的编号、姓名、年龄、商品名称

+

+ 数据:用户的编号、姓名、年龄在 user 表,商品名称在 product 表,中间表 us_pro

+

条件:us_pro.uid = user.id AND us_pro.pid = product.id

```mysql

@@ -2343,190 +2540,198 @@ CREATE TABLE us_pro(

-****

-

-

-

-

+***

-## 事务机制

-### 事务介绍

-事务(Transaction)是访问和更新数据库的程序执行单元;事务中可能包含一个或多个 sql 语句,这些语句要么都执行,要么都不执行。作为一个关系型数据库,MySQL 支持事务。

-单元中的每条 SQL 语句都相互依赖,形成一个整体

-* 如果某条 SQL 语句执行失败或者出现错误,那么整个单元就会回滚,撤回到事务最初的状态

+## 高级结构

-* 如果单元中所有的 SQL 语句都执行成功,则事务就顺利执行

+### 视图

+#### 基本介绍

+视图概念:视图是一种虚拟存在的数据表,这个虚拟的表并不在数据库中实际存在

-***

+本质:将一条 SELECT 查询语句的结果封装到了一个虚拟表中,所以在创建视图的时候,工作重心要放在这条 SELECT 查询语句上

+作用:将一些比较复杂的查询语句的结果,封装到一个虚拟表中,再有相同查询需求时,直接查询该虚拟表

+优点:

-### 管理事务

+* 简单:使用视图的用户不需要关心表的结构、关联条件和筛选条件,因为虚拟表中已经是过滤好的结果集

+* 安全:使用视图的用户只能访问查询的结果集,对表的权限管理并不能限制到某个行某个列

-管理事务的三个步骤

+* 数据独立,一旦视图的结构确定,可以屏蔽表结构变化对用户的影响,源表增加列对视图没有影响;源表修改列名,则可以通过修改视图来解决,不会造成对访问者的影响

-1. 开启事务:记录回滚点,并通知服务器,将要执行一组操作,要么同时成功、要么同时失败

-2. 执行 SQL 语句:执行具体的一条或多条 SQL 语句

-3. 结束事务(提交|回滚)

+***

- - 提交:没出现问题,数据进行更新

- - 回滚:出现问题,数据恢复到开启事务时的状态

-事务操作:

+#### 视图创建

-* 开启事务

+* 创建视图

```mysql

- START TRANSACTION;

+ CREATE [OR REPLACE]

+ VIEW 视图名称 [(列名列表)]

+ AS 查询语句

+ [WITH [CASCADED | LOCAL] CHECK OPTION];

```

-* 回滚事务

+ `WITH [CASCADED | LOCAL] CHECK OPTION` 决定了是否允许更新数据使记录不再满足视图的条件:

- ```mysql

- ROLLBACK;

- ```

+ * LOCAL:只要满足本视图的条件就可以更新

+ * CASCADED:必须满足所有针对该视图的所有视图的条件才可以更新, 默认值

-* 提交事务,显示执行是手动提交,MySQL 默认为自动提交

+* 例如

```mysql

- COMMIT;

+ -- 数据准备 city

+ id NAME cid

+ 1 深圳 1

+ 2 上海 1

+ 3 纽约 2

+ 4 莫斯科 3

+

+ -- 数据准备 country

+ id NAME

+ 1 中国

+ 2 美国

+ 3 俄罗斯

+

+ -- 创建city_country视图,保存城市和国家的信息(使用指定列名)

+ CREATE

+ VIEW

+ city_country (city_id,city_name,country_name)

+ AS

+ SELECT

+ c1.id,

+ c1.name,

+ c2.name

+ FROM

+ city c1,

+ country c2

+ WHERE

+ c1.cid=c2.id;

```

- 工作原理:

+

- * 自动提交模式下,如果没有 start transaction 显式地开始一个事务,那么**每个 SQL 语句都会被当做一个事务执行提交操作**

- * 手动提交模式下,所有的 SQL 语句都在一个事务中,直到执行了 commit 或 rollback,该事务结束的同时开启另外一个事务

+***

- * 存在一些特殊的命令,在事务中执行了这些命令会马上强制执行 COMMIT 提交事务,如 DDL 语句 (create/drop/alter/table)、lock tables 语句等

- 提交方式语法:

- - 查看事务提交方式

+#### 视图查询

- ```mysql

- SELECT @@AUTOCOMMIT; -- 1 代表自动提交 0 代表手动提交

- ```

+* 查询所有数据表,视图也会查询出来

- - 修改事务提交方式

+ ```mysql

+ SHOW TABLES;

+ SHOW TABLE STATUS [\G];

+ ```

- ```mysql

- SET @@AUTOCOMMIT=数字; -- 系统

- SET AUTOCOMMIT=数字; -- 会话

- ```

-

- - 系统变量的操作:

-

- ```sql

- SET [GLOBAL|SESSION] 变量名 = 值; -- 默认是会话

- SET @@[(GLOBAL|SESSION).]变量名 = 值; -- 默认是系统

- ```

-

- ```sql

- SHOW [GLOBAL|SESSION] VARIABLES [LIKE '变量%']; -- 默认查看会话内系统变量值

- ```

+* 查询视图

-

+ ```mysql

+ SELECT * FROM 视图名称;

+ ```

-* 管理实务演示

+* 查询某个视图创建

```mysql

- -- 开启事务

- START TRANSACTION;

-

- -- 张三给李四转账500元

- -- 1.张三账户-500

- UPDATE account SET money=money-500 WHERE NAME='张三';

- -- 2.李四账户+500

- UPDATE account SET money=money+500 WHERE NAME='李四';

-

- -- 回滚事务(出现问题)

- ROLLBACK;

-

- -- 提交事务(没出现问题)

- COMMIT;

+ SHOW CREATE VIEW 视图名称;

```

-

-

***

-### 四大特征

-

-#### ACID

-

-事务的四大特征:ACID

-

-- 原子性 (atomicity)

-- 一致性 (consistency)

-- 隔离性 (isolaction)

-- 持久性 (durability)

+#### 视图修改

+视图表数据修改,会**自动修改源表中的数据**,因为更新的是视图中的基表中的数据

+* 修改视图表中的数据

-***

+ ```mysql

+ UPDATE 视图名称 SET 列名 = 值 WHERE 条件;

+ ```

+* 修改视图的结构

+ ```mysql

+ ALTER [ALGORITHM = {UNDEFINED | MERGE | TEMPTABLE}]

+ VIEW 视图名称 [(列名列表)]

+ AS 查询语句

+ [WITH [CASCADED | LOCAL] CHECK OPTION]

+

+ -- 将视图中的country_name修改为name

+ ALTER

+ VIEW

+ city_country (city_id,city_name,name)

+ AS

+ SELECT

+ c1.id,

+ c1.name,

+ c2.name

+ FROM

+ city c1,

+ country c2

+ WHERE

+ c1.cid=c2.id;

+ ```

-#### 原子性

-原子性是指事务是一个不可分割的工作单位,事务的操作如果成功就必须要完全应用到数据库,失败则不能对数据库有任何影响。比如事务中一个 SQL 语句执行失败,则已执行的语句也必须回滚,数据库退回到事务前的状态

-InnoDB 存储引擎提供了两种事务日志:redo log(重做日志)和 undo log(回滚日志)

+***

-* redo log 用于保证事务持久性

-* undo log 用于保证事务原子性和隔离性

-undo log 属于逻辑日志,根据每行操作进行记录,记录了 SQL 执行相关的信息,用来回滚行记录到某个版本

-当事务对数据库进行修改时,InnoDB 会先记录对应的 undo log,如果事务执行失败或调用了 rollback 导致事务回滚,InnoDB 会根据 undo log 的内容**做与之前相反的操作**:

+#### 视图删除

-* 对于每个 insert,回滚时会执行 delete

+* 删除视图

-* 对于每个 delete,回滚时会执行 insert

+ ```mysql

+ DROP VIEW 视图名称;

+ ```

-* 对于每个 update,回滚时会执行一个相反的 update,把数据修改回去

+* 如果存在则删除

-undo log 是采用段(segment)的方式来记录,每个 undo 操作在记录的时候占用一个 undo log segment

+ ```mysql

+ DROP VIEW IF EXISTS 视图名称;

+ ```

-rollback segment 称为回滚段,每个回滚段中有 1024 个 undo log segment

-* 在以前老版本,只支持 1 个 rollback segment,只能记录 1024 个 undo log segment

-* MySQL5.5 开始支持 128 个 rollback segment,支持 128*1024 个 undo 操作

-参考文章:https://www.cnblogs.com/kismetv/p/10331633.html

+***

-***

+### 存储过程

+#### 基本介绍

-#### 一致性

+存储过程和函数:存储过程和函数是事先经过编译并存储在数据库中的一段 SQL 语句的集合

-一致性是指事务执行前后,数据库的完整性约束没有被破坏,事务执行的前后都是合法的数据状态。

+存储过程和函数的好处:

-数据库的完整性约束包括但不限于:实体完整性(如行的主键存在且唯一)、列完整性(如字段的类型、大小、长度要符合要求)、外键约束、用户自定义完整性(如转账前后,两个账户余额的和应该不变)

+* 提高代码的复用性

+* 减少数据在数据库和应用服务器之间的传输,提高传输效率

+* 减少代码层面的业务处理

+* **一次编译永久有效**

-实现一致性的措施:

+存储过程和函数的区别:

-- 保证原子性、持久性和隔离性,如果这些特性无法保证,事务的一致性也无法保证

-- 数据库本身提供保障,例如不允许向整形列插入字符串值、字符串长度不能超过列的限制等

-- 应用层面进行保障,例如如果转账操作只扣除转账者的余额,而没有增加接收者的余额,无论数据库实现的多么完美,也无法保证状态的一致

+* 存储函数必须有返回值

+* 存储过程可以没有返回值

@@ -2534,80 +2739,138 @@ rollback segment 称为回滚段,每个回滚段中有 1024 个 undo log segme

-#### 隔离性

-

-隔离性是指,事务内部的操作与其他事务是隔离的,多个并发事务之间要相互隔离,不能互相干扰

+#### 基本操作

-* 严格的隔离性,对应了事务隔离级别中的 serializable,实际应用中对性能考虑很少使用可串行化

+DELIMITER:

-* 与原子性、持久性侧重于研究事务本身不同,隔离性研究的是**不同事务**之间的相互影响

+* DELIMITER 关键字用来声明 sql 语句的分隔符,告诉 MySQL 该段命令已经结束

-隔离性让并发情形下的事务之间互不干扰:

+* MySQL 语句默认的分隔符是分号,但是有时需要一条功能 sql 语句中包含分号,但是并不作为结束标识,这时使用 DELIMITER 来指定分隔符:

-- 一个事务的写操作对另一个事务的写操作(写写):锁机制保证隔离性

-- 一个事务的写操作对另一个事务的读操作(读写):MVCC 保证隔离性

+ ```mysql

+ DELIMITER 分隔符

+ ```

-锁机制:事务在修改数据之前,需要先获得相应的锁,获得锁之后,事务便可以修改数据;该事务操作期间,这部分数据是锁定的,其他事务如果需要修改数据,需要等待当前事务提交或回滚后释放锁(详解见锁机制)

+存储过程的创建调用查看和删除:

+* 创建存储过程

+ ```mysql

+ -- 修改分隔符为$

+ DELIMITER $

+

+ -- 标准语法

+ CREATE PROCEDURE 存储过程名称(参数...)

+ BEGIN

+ sql语句;

+ END$

+

+ -- 修改分隔符为分号

+ DELIMITER ;

+ ```

-***

+* 调用存储过程

+ ```mysql

+ CALL 存储过程名称(实际参数);

+ ```

+* 查看存储过程

-#### 持久性

+ ```mysql

+ SELECT * FROM mysql.proc WHERE db='数据库名称';

+ ```

-##### 实现原理

+* 删除存储过程

-持久性是指一个事务一旦被提交了,那么对数据库中数据的改变就是永久性的,接下来的其他操作或故障不应该对其有任何影响。

+ ```mysql

+ DROP PROCEDURE [IF EXISTS] 存储过程名称;

+ ```

-Buffer Pool 是一片内存空间,可以通过 innodb_buffer_pool_size 来控制 Buffer Pool 的大小(内存优化部分会详解参数)

+练习:

-* Change Buffer 是 Buffer Pool 里的内存,不能无限增大,用来对增删改操作提供缓存

-* Change Buffer 的大小可以通过参数 innodb_change_buffer_max_size 来动态设置,设置为 50 时表示 Change Buffer 的大小最多只能占用 Buffer Pool 的 50%

-* 补充知识:**唯一索引的更新不能使用 Buffer**,一般只有普通索引可以使用,直接写入 Buffer 就结束

+* 数据准备

-InnoDB 的数据是按数据页为单位来读写,每个数据页的大小默认是 16KB。数据是存放在磁盘中,每次读写数据都需要磁盘 IO,效率会很低。InnoDB 提供了缓存 Change Buffer,Buffer 中包含了磁盘中部分数据页的映射,作为访问数据库的缓冲:

+ ```mysql

+ id NAME age gender score

+ 1 张三 23 男 95

+ 2 李四 24 男 98

+ 3 王五 25 女 100

+ 4 赵六 26 女 90

+ ```

-* 从数据库读取数据时,会首先从缓存中读取,如果缓存中没有,则从磁盘读取后放入 Buffer Pool

-* 向数据库写入数据时,会首先写入缓存,缓存中修改的数据会**定期刷新**到磁盘,这一过程称为刷脏

+* 创建 stu_group() 存储过程,封装分组查询总成绩,并按照总成绩升序排序的功能

+ ```mysql

+ DELIMITER $

+

+ CREATE PROCEDURE stu_group()

+ BEGIN

+ SELECT gender,SUM(score) getSum FROM student GROUP BY gender ORDER BY getSum ASC;

+ END$

+

+ DELIMITER ;

+

+ -- 调用存储过程

+ CALL stu_group();

+ -- 删除存储过程

+ DROP PROCEDURE IF EXISTS stu_group;

+ ```

+

***

-##### 数据恢复

-

-Buffer Pool 的使用提高了读写数据的效率,但是也带了新的问题:如果 MySQL 宕机,此时 Buffer Pool 中修改的数据还没有刷新到磁盘,就会导致数据的丢失,事务的持久性无法保证,所以引入 redo log

-

-* 当数据修改时,先修改 Change Buffer 中的数据,然后在 redo log buffer 记录这次操作

-* 如果 MySQL 宕机,InnoDB 判断一个数据页在崩溃恢复时丢失了更新,就会将它读到内存,然后根据 redo log 内容更新内存,更新完成后,内存页变成脏页,然后进行刷脏(buffer pool 的任务)

+#### 存储语法

-redo log **记录数据页的物理修改**,而不是某一行或某几行的修改,用来恢复提交后的物理数据页,且只能恢复到最后一次提交的位置

+##### 变量使用

-redo log 采用的是 WAL(Write-ahead logging,**预写式日志**),所有修改要先写入日志,再更新到磁盘,保证了数据不会因 MySQL 宕机而丢失,从而满足了持久性要求

+存储过程是可以进行编程的,意味着可以使用变量、表达式、条件控制语句等,来完成比较复杂的功能

-redo log 也需要在事务提交时将日志写入磁盘,但是比将内存中的 Buffer Pool 修改的数据写入磁盘的速度快:

+* 定义变量:DECLARE 定义的是局部变量,只能用在 BEGIN END 范围之内

+

+ ```mysql

+ DECLARE 变量名 数据类型 [DEFAULT 默认值];

+ ```

+

+* 变量的赋值

-* 刷脏是随机 IO,因为每次修改的数据位置随机,但写 redo log 是尾部追加操作,属于顺序 IO

-* 刷脏是以数据页(Page)为单位的,一个页上的一个小修改都要整页写入,而 redo log 中只包含真正需要写入的部分,减少无效 IO

+ ```mysql

+ SET 变量名 = 变量值;

+ SELECT 列名 INTO 变量名 FROM 表名 [WHERE 条件];

+ ```

-InnoDB 引擎会在适当的时候,把内存中 redo log buffer 持久化到磁盘,具体的刷盘策略:

+* 数据准备:表 student

-* 通过修改参数 `innodb_flush_log_at_trx_commit` 设置:

- * 0:表示当提交事务时,并不将缓冲区的 redo 日志写入磁盘,而是等待主线程每秒刷新一次

- * 1:在事务提交时将缓冲区的 redo 日志**同步写入**到磁盘,保证一定会写入成功

- * 2:在事务提交时将缓冲区的 redo 日志异步写入到磁盘,不能保证提交时肯定会写入,只是有这个动作

-* 如果写入 redo log buffer 的日志已经占据了 redo log buffer 总容量的一半了,此时就会刷入到磁盘文件,这时会影响执行效率,所以开发中应该**避免大事务**

+ ```mysql

+ id NAME age gender score

+ 1 张三 23 男 95

+ 2 李四 24 男 98

+ 3 王五 25 女 100

+ 4 赵六 26 女 90

+ ```

-刷脏策略:

+* 定义两个 int 变量,用于存储男女同学的总分数

-* redo log 文件是固定大小的,如果写满了就要擦除以前的记录,在擦除之前需要把旧记录更新到磁盘中的数据文件中

-* Buffer Pool 内存不足,需要淘汰部分数据页,如果淘汰的是脏页,就要先将脏页写到磁盘(大事务)

-* 系统空闲时,后台线程会自动进行刷脏

-* MySQL 正常关闭时,会把内存的脏页都 flush 到磁盘上

+ ```mysql

+ DELIMITER $

+ CREATE PROCEDURE pro_test3()

+ BEGIN

+ -- 定义两个变量

+ DECLARE men,women INT;

+ -- 查询男同学的总分数,为men赋值

+ SELECT SUM(score) INTO men FROM student WHERE gender='男';

+ -- 查询女同学的总分数,为women赋值

+ SELECT SUM(score) INTO women FROM student WHERE gender='女';

+ -- 使用变量

+ SELECT men,women;

+ END$

+ DELIMITER ;

+ -- 调用存储过程

+ CALL pro_test3();

+ ```

@@ -2615,186 +2878,414 @@ InnoDB 引擎会在适当的时候,把内存中 redo log buffer 持久化到

-##### 工作流程

-

-MySQL中还存在 binlog(二进制日志)也可以记录写操作并用于数据的恢复,**保证数据不丢失**,二者的区别是:

-

-* 作用不同:redo log 是用于 crash recovery (故障恢复),保证 MySQL 宕机也不会影响持久性;binlog 是用于 point-in-time recovery 的,保证服务器可以基于时间点恢复数据,此外 binlog 还用于主从复制

-

-* 层次不同:redo log 是 InnoDB 存储引擎实现的,而 binlog 是MySQL的服务器层实现的,同时支持 InnoDB 和其他存储引擎

-

-* 内容不同:redo log 是物理日志,内容基于磁盘的 Page;binlog 的内容是二进制的,根据 binlog_format 参数的不同,可能基于SQL 语句、基于数据本身或者二者的混合(日志部分详解)

-

-* 写入时机不同:binlog 在事务提交时一次写入;redo log 的写入时机相对多元

+##### IF语句

-两种日志在 update 更新数据的**作用时机**:

+* if 语句标准语法

-```sql

-update T set c=c+1 where ID=2;

-```

+ ```mysql

+ IF 判断条件1 THEN 执行的sql语句1;

+ [ELSEIF 判断条件2 THEN 执行的sql语句2;]

+ ...

+ [ELSE 执行的sql语句n;]

+ END IF;

+ ```

- +* 数据准备:表 student

-流程说明:执行引擎将这行新数据更新到内存中(Buffer Pool)后,然后会将这个更新操作记录到 redo log buffer 里,此时 redo log 处于 prepare 状态,代表执行完成随时可以提交事务,然后执行器生成这个操作的 binlog 并**把 binlog 写入磁盘**,在提交事务后 **redo log 也持久化到磁盘**

+ ```mysql

+ id NAME age gender score

+ 1 张三 23 男 95

+ 2 李四 24 男 98

+ 3 王五 25 女 100

+ 4 赵六 26 女 90

+ ```

+

+* 根据总成绩判断:全班 380 分及以上学习优秀、320 ~ 380 学习良好、320 以下学习一般

-redo log 和 binlog 都可以用于表示事务的提交状态,而**两阶段提交就是让这两个状态保持逻辑上的一致**,也有利于主从复制,更好的保持主从数据的一致性

+ ```mysql

+ DELIMITER $

+ CREATE PROCEDURE pro_test4()

+ BEGIN

+ DECLARE total INT; -- 定义总分数变量

+ DECLARE description VARCHAR(10); -- 定义分数描述变量

+ SELECT SUM(score) INTO total FROM student; -- 为总分数变量赋值

+ -- 判断总分数

+ IF total >= 380 THEN

+ SET description = '学习优秀';

+ ELSEIF total >=320 AND total < 380 THEN

+ SET description = '学习良好';

+ ELSE

+ SET description = '学习一般';

+ END IF;

+ END$

+ DELIMITER ;

+ -- 调用pro_test4存储过程

+ CALL pro_test4();

+ ```

-故障恢复数据:

-* 如果在时刻 A 发生了崩溃(crash),由于此时 binlog 还没写,redo log 也没提交,所以数据恢复的时候这个事务会回滚

-* 如果在时刻 B 发生了崩溃,redo log 和 binlog 有一个共同的数据字段叫 XID,崩溃恢复的时候,会按顺序扫描 redo log:

- * 如果 redo log 里面的事务是完整的,也就是已经有了 commit 标识,说明 binlog 也已经记录完整,直接从 redo log 恢复数据

- * 如果 redo log 里面的事务只有 prepare,就根据 XID 去 binlog 中判断对应的事务是否存在并完整,如果完整可以从 binlog 恢复 redo log 的信息,进而恢复数据,提交事务

-判断一个事务的 binlog 是否完整的方法:

+***

-* statement 格式的 binlog,最后会有 COMMIT

-* row 格式的 binlog,最后会有一个 XID event

-* MySQL 5.6.2 版本以后,引入了 binlog-checksum 参数用来验证 binlog 内容的正确性

+##### 参数传递

-参考文章:https://time.geekbang.org/column/article/73161

+* 参数传递的语法

+ IN:代表输入参数,需要由调用者传递实际数据,默认的

+ OUT:代表输出参数,该参数可以作为返回值

+ INOUT:代表既可以作为输入参数,也可以作为输出参数

+ ```mysql

+ DELIMITER $

+

+ -- 标准语法

+ CREATE PROCEDURE 存储过程名称([IN|OUT|INOUT] 参数名 数据类型)

+ BEGIN

+ 执行的sql语句;

+ END$

+

+ DELIMITER ;

+ ```

-***

+* 输入总成绩变量,代表学生总成绩,输出分数描述变量,代表学生总成绩的描述

+ ```mysql

+ DELIMITER $

+

+ CREATE PROCEDURE pro_test6(IN total INT, OUT description VARCHAR(10))

+ BEGIN

+ -- 判断总分数

+ IF total >= 380 THEN

+ SET description = '学习优秀';

+ ELSEIF total >= 320 AND total < 380 THEN

+ SET description = '学习不错';

+ ELSE

+ SET description = '学习一般';

+ END IF;

+ END$

+

+ DELIMITER ;

+ -- 调用pro_test6存储过程

+ CALL pro_test6(310,@description);

+ CALL pro_test6((SELECT SUM(score) FROM student), @description);

+ -- 查询总成绩描述

+ SELECT @description;

+ ```

+* 查看参数方法

-##### 系统优化

+ * @变量名 : **用户会话变量**,代表整个会话过程他都是有作用的,类似于全局变量

+ * @@变量名 : **系统变量**

-系统在进行刷脏时会占用一部分系统资源,会影响系统的性能,产生系统抖动

+

-* 一个查询要淘汰的脏页个数太多,会导致查询的响应时间明显变长

-* 日志写满,更新全部堵住,写性能跌为 0,这种情况对敏感业务来说,是不能接受的

+***

-InnoDB 刷脏页的控制策略:

-* `innodb_io_capacity` 参数代表磁盘的读写能力,建议设置成磁盘的 IOPS(每秒的 IO 次数)

-* 刷脏速度参考两个因素:脏页比例和 redo log 写盘速度

- * 参数 `innodb_max_dirty_pages_pct` 是脏页比例上限,默认值是 75%,InnoDB 会根据当前的脏页比例,算出一个范围在 0 到 100 之间的数字

- * InnoDB 每次写入的日志都有一个序号,当前写入的序号跟 checkpoint 对应的序号之间的差值,InnoDB 根据差值算出一个范围在 0 到 100 之间的数字

- * 两者较大的值记为 R,执行引擎按照 innodb_io_capacity 定义的能力乘以 R% 来控制刷脏页的速度

+##### CASE

-* `innodb_flush_neighbors` 参数置为 1 代表控制刷脏时检查相邻的数据页,如果也是脏页就一起刷脏,并检查邻居的邻居,这个行为会一直蔓延直到不是脏页,在 MySQL 8.0 中该值的默认值是 0,不建议开启此功能

+* 标准语法 1

+ ```mysql

+ CASE 表达式

+ WHEN 值1 THEN 执行sql语句1;

+ [WHEN 值2 THEN 执行sql语句2;]

+ ...

+ [ELSE 执行sql语句n;]

+ END CASE;

+ ```

+* 标准语法 2

+ ```mysql

+ sCASE

+ WHEN 判断条件1 THEN 执行sql语句1;

+ [WHEN 判断条件2 THEN 执行sql语句2;]

+ ...

+ [ELSE 执行sql语句n;]

+ END CASE;

+ ```

+* 演示

-***

+ ```mysql

+ DELIMITER $

+ CREATE PROCEDURE pro_test7(IN total INT)

+ BEGIN

+ -- 定义变量

+ DECLARE description VARCHAR(10);

+ -- 使用case判断

+ CASE

+ WHEN total >= 380 THEN

+ SET description = '学习优秀';

+ WHEN total >= 320 AND total < 380 THEN

+ SET description = '学习不错';

+ ELSE

+ SET description = '学习一般';

+ END CASE;

+

+ -- 查询分数描述信息

+ SELECT description;

+ END$

+ DELIMITER ;

+ -- 调用pro_test7存储过程

+ CALL pro_test7(390);

+ CALL pro_test7((SELECT SUM(score) FROM student));

+ ```

-### 隔离级别

+***

-事务的隔离级别:多个客户端操作时,各个客户端的事务之间应该是隔离的,**不同的事务之间不该互相影响**,而如果多个事务操作同一批数据时,则需要设置不同的隔离级别,否则就会产生问题。

-隔离级别分类:

-| 隔离级别 | 名称 | 会引发的问题 | 数据库默认隔离级别 |

-| ---------------- | -------- | -------------------------------- | ------------------- |

-| read uncommitted | 读未提交 | 脏读、不可重复读、幻读 | |

-| read committed | 读已提交 | 不可重复读、幻读 | Oracle / SQL Server |

-| repeatable read | 可重复读 | 幻读 | MySQL |

-| serializable | 串行化 | 无(因为写会加写锁,读会加读锁) | |

+##### WHILE

-一般来说,隔离级别越低,系统开销越低,可支持的并发越高,但隔离性也越差

+* while 循环语法

+

+ ```mysql

+ WHILE 条件判断语句 DO

+ 循环体语句;

+ 条件控制语句;

+ END WHILE;

+ ```

+

+* 计算 1~100 之间的偶数和

+

+ ```mysql

+ DELIMITER $

+ CREATE PROCEDURE pro_test6()

+ BEGIN

+ -- 定义求和变量

+ DECLARE result INT DEFAULT 0;

+ -- 定义初始化变量

+ DECLARE num INT DEFAULT 1;

+ -- while循环

+ WHILE num <= 100 DO

+ IF num % 2 = 0 THEN

+ SET result = result + num;

+ END IF;

+ SET num = num + 1;

+ END WHILE;

+ -- 查询求和结果

+ SELECT result;

+ END$

+ DELIMITER ;

+

+ -- 调用pro_test6存储过程

+ CALL pro_test6();

+ ```

-* 丢失更新 (Lost Update):当两个或多个事务选择同一行,最初的事务修改的值,被后面事务修改的值覆盖,所有的隔离级别都可以避免丢失更新(行锁)

-* 脏读 (Dirty Reads):在事务中先后两次读取同一个数据,两次读取的结果不一样,原因是在一个事务处理过程中读取了另一个**未提交**的事务中的数据

-* 不可重复读 (Non-Repeatable Reads):在事务中先后两次读取同一个数据,两次读取的结果不一样,原因是在一个事务处理过程中读取了另一个事务中修改并**已提交**的数据

+***

- > 可重复读的意思是不管读几次,结果都一样,可以重复的读,可以理解为快照读,要读的数据集不会发生变化

-* 幻读 (Phantom Reads):在事务中按某个条件先后两次查询数据库,后一次查询查到了前一次查询没有查到的行,**数据条目**发生了变化。比如查询某数据不存在,准备插入此记录,但执行插入时发现此记录已存在,无法插入

-**隔离级别操作语法:**

+##### REPEAT

-* 查询数据库隔离级别

+* repeat 循环标准语法

```mysql

- SELECT @@TX_ISOLATION;

- SHOW VARIABLES LIKE 'tx_isolation';

+ 初始化语句;

+ REPEAT

+ 循环体语句;

+ 条件控制语句;

+ UNTIL 条件判断语句

+ END REPEAT;

```

-* 修改数据库隔离级别

+* 计算 1~10 之间的和

```mysql

- SET GLOBAL TRANSACTION ISOLATION LEVEL 级别字符串;

+ DELIMITER $

+ CREATE PROCEDURE pro_test9()

+ BEGIN

+ -- 定义求和变量

+ DECLARE result INT DEFAULT 0;

+ -- 定义初始化变量

+ DECLARE num INT DEFAULT 1;

+ -- repeat循环

+ REPEAT

+ -- 累加

+ SET result = result + num;

+ -- 让num+1

+ SET num = num + 1;

+ -- 停止循环

+ UNTIL num > 10

+ END REPEAT;

+ -- 查询求和结果

+ SELECT result;

+ END$

+

+ DELIMITER ;

+ -- 调用pro_test9存储过程

+ CALL pro_test9();

```

-***

+***

-### 并发控制

-#### MVCC

+##### LOOP

-MVCC 全称 Multi-Version Concurrency Control,即多版本并发控制,用来**解决读写冲突的无锁并发控制**

+LOOP 实现简单的循环,退出循环的条件需要使用其他的语句定义,通常可以使用 LEAVE 语句实现,如果不加退出循环的语句,那么就变成了死循环

-MVCC 处理读写请求,可以做到在发生读写请求冲突时不用加锁,这个读是指的快照读,而不是当前读

+* loop 循环标准语法

-* 快照读:实现基于 MVCC,因为是多版本并发,所以快照读读到的数据不一定是当前最新的数据,有可能是历史版本的数据

-* 当前读:读取数据库记录是当前最新的版本(产生幻读、不可重复读),可以对读取的数据进行加锁,防止其他事务修改数据,是悲观锁的一种操作,读写操作加共享锁或者排他锁和串行化事务的隔离级别都是当前读

+ ```mysql

+ [循环名称:] LOOP

+ 条件判断语句

+ [LEAVE 循环名称;]

+ 循环体语句;

+ 条件控制语句;

+ END LOOP 循环名称;

+ ```

+

+* 计算 1~10 之间的和

-数据库并发场景:

+ ```mysql

+ DELIMITER $

+ CREATE PROCEDURE pro_test10()

+ BEGIN

+ -- 定义求和变量

+ DECLARE result INT DEFAULT 0;

+ -- 定义初始化变量

+ DECLARE num INT DEFAULT 1;

+ -- loop循环

+ l:LOOP

+ -- 条件成立,停止循环

+ IF num > 10 THEN

+ LEAVE l;

+ END IF;

+ -- 累加

+ SET result = result + num;

+ -- 让num+1

+ SET num = num + 1;

+ END LOOP l;

+ -- 查询求和结果

+ SELECT result;

+ END$

+ DELIMITER ;

+ -- 调用pro_test10存储过程

+ CALL pro_test10();

+ ```

-* 读-读:不存在任何问题,也不需要并发控制

-* 读-写:有线程安全问题,可能会造成事务隔离性问题,可能遇到脏读,幻读,不可重复读

-* 写-写:有线程安全问题,可能会存在丢失更新问题

+***

-MVCC 的优点:

-* 在并发读写数据库时,做到在读操作时不用阻塞写操作,写操作也不用阻塞读操作,提高了并发读写的性能

-* 可以解决脏读,不可重复读等事务隔离问题(加锁也能解决),但不能解决更新丢失问题

-

-提高读写和写写的并发性能:

-

-* MVCC + 悲观锁:MVCC 解决读写冲突,悲观锁解决写写冲突

-* MVCC + 乐观锁:MVCC 解决读写冲突,乐观锁解决写写冲突

+##### 游标

+游标是用来存储查询结果集的数据类型,在存储过程和函数中可以使用光标对结果集进行循环的处理

+* 游标可以遍历返回的多行结果,每次拿到一整行数据

+* 简单来说游标就类似于集合的迭代器遍历

+* MySQL 中的游标只能用在存储过程和函数中

-参考文章:https://www.jianshu.com/p/8845ddca3b23

+游标的语法

+* 创建游标

+ ```mysql

+ DECLARE 游标名称 CURSOR FOR 查询sql语句;

+ ```

-***

+* 打开游标

+ ```mysql

+ OPEN 游标名称;

+ ```

+* 使用游标获取数据

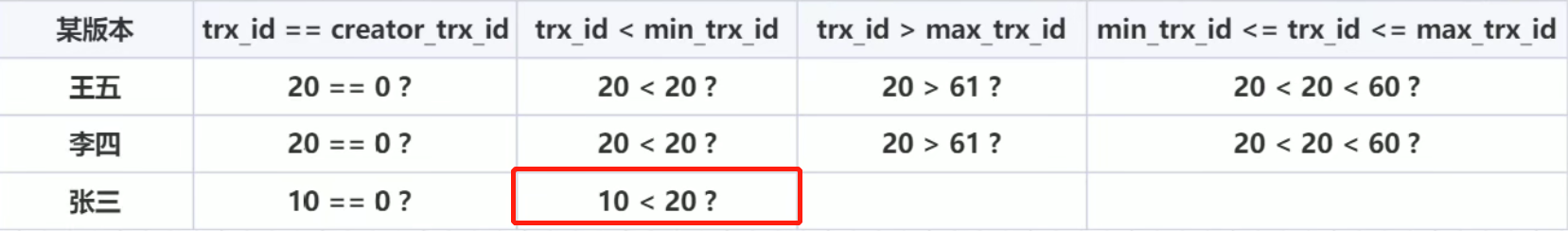

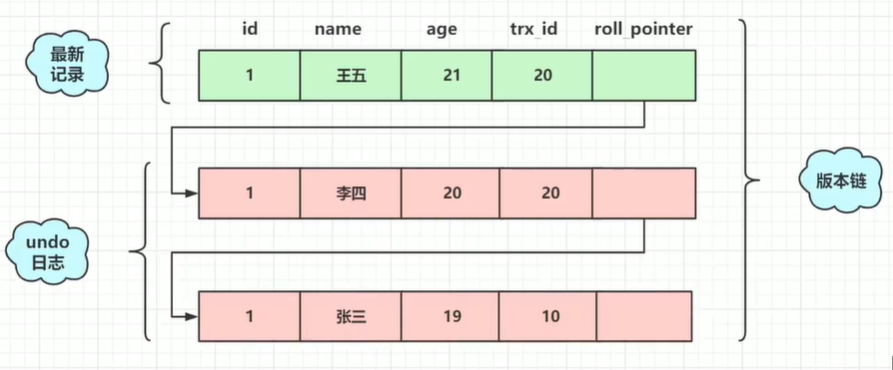

-#### 原理

+ ```mysql

+ FETCH 游标名称 INTO 变量名1,变量名2,...;

+ ```

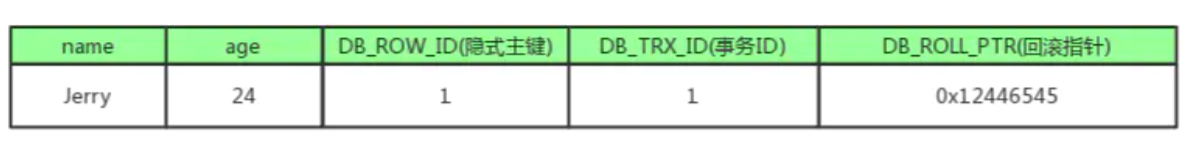

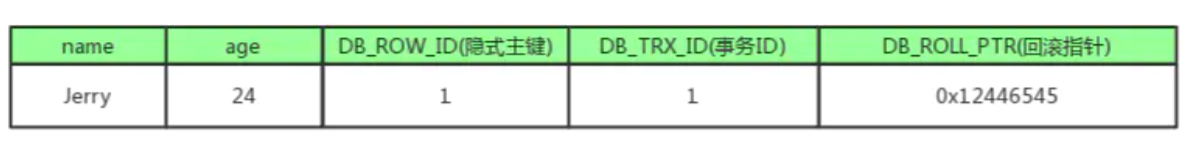

-##### 隐藏字段

+* 关闭游标

-实现原理主要是隐藏字段,undo日志,Read View 来实现的

+ ```mysql

+ CLOSE 游标名称;

+ ```

-数据库中的每行数据,除了自定义的字段,还有数据库隐式定义的字段:

+* Mysql 通过一个 Error handler 声明来判断指针是否到尾部,并且必须和创建游标的 SQL 语句声明在一起:

-* DB_TRX_ID:6byte,最近修改事务ID,记录创建该数据或最后一次修改(修改/插入)该数据的事务ID。当每个事务开启时,都会被分配一个ID,这个 ID 是递增的

+ ```mysql

+ DECLARE EXIT HANDLER FOR NOT FOUND (do some action,一般是设置标志变量)

+ ```

-* DB_ROLL_PTR:7byte,回滚指针,配合 undo 日志,指向上一个旧版本(存储在 rollback segment)

+

-* DB_ROW_ID:6byte,隐含的自增ID(**隐藏主键**),如果数据表没有主键,InnoDB 会自动以 DB_ROW_ID 作为聚簇索引

+游标的基本使用

-* DELETED_BIT:删除标志的隐藏字段,记录被更新或删除并不代表真的删除,而是删除位变了

+* 数据准备:表 student

-

+ ```mysql

+ id NAME age gender score

+ 1 张三 23 男 95

+ 2 李四 24 男 98

+ 3 王五 25 女 100

+ 4 赵六 26 女 90

+ ```

+* 创建 stu_score 表

+ ```mysql

+ CREATE TABLE stu_score(

+ id INT PRIMARY KEY AUTO_INCREMENT,

+ score INT

+ );

+ ```

+* 将student表中所有的成绩保存到stu_score表中

+ ```mysql

+ DELIMITER $

+

+ CREATE PROCEDURE pro_test12()

+ BEGIN

+ -- 定义成绩变量

+ DECLARE s_score INT;

+ -- 定义标记变量

+ DECLARE flag INT DEFAULT 0;

+

+ -- 创建游标,查询所有学生成绩数据

+ DECLARE stu_result CURSOR FOR SELECT score FROM student;

+ -- 游标结束后,将标记变量改为1 这两个必须声明在一起

+ DECLARE EXIT HANDLER FOR NOT FOUND SET flag = 1;

+

+ -- 开启游标

+ OPEN stu_result;

+ -- 循环使用游标

+ REPEAT

+ -- 使用游标,遍历结果,拿到数据

+ FETCH stu_result INTO s_score;

+ -- 将数据保存到stu_score表中

+ INSERT INTO stu_score VALUES (NULL,s_score);

+ UNTIL flag=1

+ END REPEAT;

+ -- 关闭游标

+ CLOSE stu_result;

+ END$

+

+ DELIMITER ;

+

+ -- 调用pro_test12存储过程

+ CALL pro_test12();

+ -- 查询stu_score表

+ SELECT * FROM stu_score;

+ ```

+

+

@@ -2802,34 +3293,59 @@ MVCC 的优点:

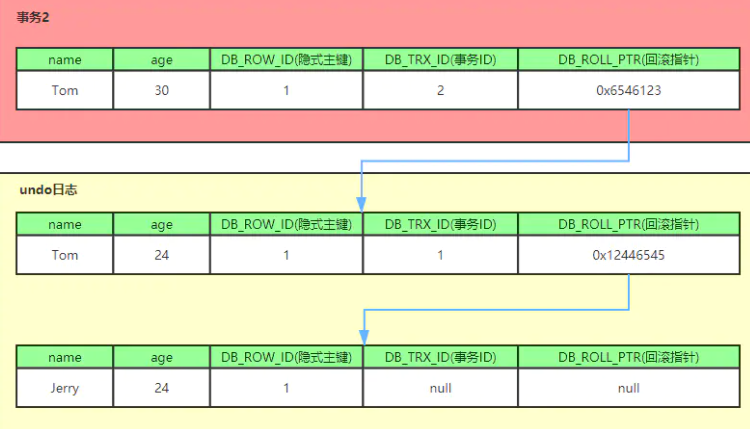

-##### undo

+#### 存储函数

-undo log 是逻辑日志,记录的是每个事务对数据执行的操作,而不是记录的全部数据,需要根据 undo log 逆推出以往事务的数据

+存储函数和存储过程是非常相似的,存储函数可以做的事情,存储过程也可以做到

-undo log 的作用:

+存储函数有返回值,存储过程没有返回值(参数的 out 其实也相当于是返回数据了)

-* 保证事务进行 rollback 时的原子性和一致性,当事务进行回滚的时候可以用 undo log 的数据进行恢复

-* 用于 MVCC 快照读,通过读取 undo log 的历史版本数据可以实现不同事务版本号都拥有自己独立的快照数据版本

+* 创建存储函数

-undo log 主要分为两种:

+ ```mysql

+ DELIMITER $

+ -- 标准语法

+ CREATE FUNCTION 函数名称(参数 数据类型)

+ RETURNS 返回值类型

+ BEGIN

+ 执行的sql语句;

+ RETURN 结果;

+ END$

+

+ DELIMITER ;

+ ```

-* insert undo log:事务在 insert 新记录时产生的 undo log,只在事务回滚时需要,并且在事务提交后可以被立即丢弃

+* 调用存储函数,因为有返回值,所以使用 SELECT 调用

-* update undo log:事务在进行 update 或 delete 时产生的 undo log,在事务回滚时需要,在快照读时也需要。不能随意删除,只有在快速读或事务回滚不涉及该日志时,对应的日志才会被 purge 线程统一清除

+ ```mysql

+ SELECT 函数名称(实际参数);

+ ```

-每次对数据库记录进行改动,都会将旧值放到一条 undo 日志中,算是该记录的一个旧版本,随着更新次数的增多,所有的版本都会被 roll_pointer 属性连接成一个链表,把这个链表称之为**版本链**,版本链的头节点就是当前记录最新的值,链尾就是最早的旧记录

+* 删除存储函数

-

+* 数据准备:表 student

-流程说明:执行引擎将这行新数据更新到内存中(Buffer Pool)后,然后会将这个更新操作记录到 redo log buffer 里,此时 redo log 处于 prepare 状态,代表执行完成随时可以提交事务,然后执行器生成这个操作的 binlog 并**把 binlog 写入磁盘**,在提交事务后 **redo log 也持久化到磁盘**

+ ```mysql

+ id NAME age gender score

+ 1 张三 23 男 95

+ 2 李四 24 男 98

+ 3 王五 25 女 100

+ 4 赵六 26 女 90

+ ```

+

+* 根据总成绩判断:全班 380 分及以上学习优秀、320 ~ 380 学习良好、320 以下学习一般

-redo log 和 binlog 都可以用于表示事务的提交状态,而**两阶段提交就是让这两个状态保持逻辑上的一致**,也有利于主从复制,更好的保持主从数据的一致性

+ ```mysql

+ DELIMITER $

+ CREATE PROCEDURE pro_test4()

+ BEGIN

+ DECLARE total INT; -- 定义总分数变量

+ DECLARE description VARCHAR(10); -- 定义分数描述变量

+ SELECT SUM(score) INTO total FROM student; -- 为总分数变量赋值

+ -- 判断总分数

+ IF total >= 380 THEN

+ SET description = '学习优秀';

+ ELSEIF total >=320 AND total < 380 THEN

+ SET description = '学习良好';

+ ELSE

+ SET description = '学习一般';

+ END IF;

+ END$

+ DELIMITER ;

+ -- 调用pro_test4存储过程

+ CALL pro_test4();

+ ```

-故障恢复数据:

-* 如果在时刻 A 发生了崩溃(crash),由于此时 binlog 还没写,redo log 也没提交,所以数据恢复的时候这个事务会回滚

-* 如果在时刻 B 发生了崩溃,redo log 和 binlog 有一个共同的数据字段叫 XID,崩溃恢复的时候,会按顺序扫描 redo log:

- * 如果 redo log 里面的事务是完整的,也就是已经有了 commit 标识,说明 binlog 也已经记录完整,直接从 redo log 恢复数据

- * 如果 redo log 里面的事务只有 prepare,就根据 XID 去 binlog 中判断对应的事务是否存在并完整,如果完整可以从 binlog 恢复 redo log 的信息,进而恢复数据,提交事务

-判断一个事务的 binlog 是否完整的方法:

+***

-* statement 格式的 binlog,最后会有 COMMIT

-* row 格式的 binlog,最后会有一个 XID event

-* MySQL 5.6.2 版本以后,引入了 binlog-checksum 参数用来验证 binlog 内容的正确性

+##### 参数传递

-参考文章:https://time.geekbang.org/column/article/73161

+* 参数传递的语法

+ IN:代表输入参数,需要由调用者传递实际数据,默认的

+ OUT:代表输出参数,该参数可以作为返回值

+ INOUT:代表既可以作为输入参数,也可以作为输出参数

+ ```mysql

+ DELIMITER $

+

+ -- 标准语法

+ CREATE PROCEDURE 存储过程名称([IN|OUT|INOUT] 参数名 数据类型)

+ BEGIN

+ 执行的sql语句;

+ END$

+

+ DELIMITER ;

+ ```

-***

+* 输入总成绩变量,代表学生总成绩,输出分数描述变量,代表学生总成绩的描述

+ ```mysql

+ DELIMITER $

+

+ CREATE PROCEDURE pro_test6(IN total INT, OUT description VARCHAR(10))

+ BEGIN

+ -- 判断总分数

+ IF total >= 380 THEN

+ SET description = '学习优秀';

+ ELSEIF total >= 320 AND total < 380 THEN

+ SET description = '学习不错';

+ ELSE

+ SET description = '学习一般';

+ END IF;

+ END$

+

+ DELIMITER ;

+ -- 调用pro_test6存储过程

+ CALL pro_test6(310,@description);

+ CALL pro_test6((SELECT SUM(score) FROM student), @description);

+ -- 查询总成绩描述

+ SELECT @description;

+ ```

+* 查看参数方法

-##### 系统优化

+ * @变量名 : **用户会话变量**,代表整个会话过程他都是有作用的,类似于全局变量

+ * @@变量名 : **系统变量**

-系统在进行刷脏时会占用一部分系统资源,会影响系统的性能,产生系统抖动

+

-* 一个查询要淘汰的脏页个数太多,会导致查询的响应时间明显变长

-* 日志写满,更新全部堵住,写性能跌为 0,这种情况对敏感业务来说,是不能接受的

+***

-InnoDB 刷脏页的控制策略:

-* `innodb_io_capacity` 参数代表磁盘的读写能力,建议设置成磁盘的 IOPS(每秒的 IO 次数)

-* 刷脏速度参考两个因素:脏页比例和 redo log 写盘速度

- * 参数 `innodb_max_dirty_pages_pct` 是脏页比例上限,默认值是 75%,InnoDB 会根据当前的脏页比例,算出一个范围在 0 到 100 之间的数字

- * InnoDB 每次写入的日志都有一个序号,当前写入的序号跟 checkpoint 对应的序号之间的差值,InnoDB 根据差值算出一个范围在 0 到 100 之间的数字

- * 两者较大的值记为 R,执行引擎按照 innodb_io_capacity 定义的能力乘以 R% 来控制刷脏页的速度

+##### CASE

-* `innodb_flush_neighbors` 参数置为 1 代表控制刷脏时检查相邻的数据页,如果也是脏页就一起刷脏,并检查邻居的邻居,这个行为会一直蔓延直到不是脏页,在 MySQL 8.0 中该值的默认值是 0,不建议开启此功能

+* 标准语法 1

+ ```mysql

+ CASE 表达式

+ WHEN 值1 THEN 执行sql语句1;

+ [WHEN 值2 THEN 执行sql语句2;]

+ ...

+ [ELSE 执行sql语句n;]

+ END CASE;

+ ```

+* 标准语法 2

+ ```mysql

+ sCASE

+ WHEN 判断条件1 THEN 执行sql语句1;

+ [WHEN 判断条件2 THEN 执行sql语句2;]

+ ...

+ [ELSE 执行sql语句n;]

+ END CASE;

+ ```

+* 演示

-***

+ ```mysql

+ DELIMITER $

+ CREATE PROCEDURE pro_test7(IN total INT)

+ BEGIN

+ -- 定义变量

+ DECLARE description VARCHAR(10);

+ -- 使用case判断

+ CASE

+ WHEN total >= 380 THEN

+ SET description = '学习优秀';

+ WHEN total >= 320 AND total < 380 THEN

+ SET description = '学习不错';

+ ELSE

+ SET description = '学习一般';

+ END CASE;

+

+ -- 查询分数描述信息

+ SELECT description;

+ END$

+ DELIMITER ;

+ -- 调用pro_test7存储过程

+ CALL pro_test7(390);

+ CALL pro_test7((SELECT SUM(score) FROM student));

+ ```

-### 隔离级别

+***

-事务的隔离级别:多个客户端操作时,各个客户端的事务之间应该是隔离的,**不同的事务之间不该互相影响**,而如果多个事务操作同一批数据时,则需要设置不同的隔离级别,否则就会产生问题。

-隔离级别分类:

-| 隔离级别 | 名称 | 会引发的问题 | 数据库默认隔离级别 |

-| ---------------- | -------- | -------------------------------- | ------------------- |

-| read uncommitted | 读未提交 | 脏读、不可重复读、幻读 | |

-| read committed | 读已提交 | 不可重复读、幻读 | Oracle / SQL Server |

-| repeatable read | 可重复读 | 幻读 | MySQL |

-| serializable | 串行化 | 无(因为写会加写锁,读会加读锁) | |

+##### WHILE

-一般来说,隔离级别越低,系统开销越低,可支持的并发越高,但隔离性也越差

+* while 循环语法

+

+ ```mysql

+ WHILE 条件判断语句 DO

+ 循环体语句;

+ 条件控制语句;

+ END WHILE;

+ ```

+

+* 计算 1~100 之间的偶数和

+

+ ```mysql

+ DELIMITER $

+ CREATE PROCEDURE pro_test6()

+ BEGIN

+ -- 定义求和变量

+ DECLARE result INT DEFAULT 0;

+ -- 定义初始化变量

+ DECLARE num INT DEFAULT 1;

+ -- while循环

+ WHILE num <= 100 DO

+ IF num % 2 = 0 THEN

+ SET result = result + num;

+ END IF;

+ SET num = num + 1;

+ END WHILE;

+ -- 查询求和结果

+ SELECT result;

+ END$

+ DELIMITER ;

+

+ -- 调用pro_test6存储过程

+ CALL pro_test6();

+ ```

-* 丢失更新 (Lost Update):当两个或多个事务选择同一行,最初的事务修改的值,被后面事务修改的值覆盖,所有的隔离级别都可以避免丢失更新(行锁)

-* 脏读 (Dirty Reads):在事务中先后两次读取同一个数据,两次读取的结果不一样,原因是在一个事务处理过程中读取了另一个**未提交**的事务中的数据

-* 不可重复读 (Non-Repeatable Reads):在事务中先后两次读取同一个数据,两次读取的结果不一样,原因是在一个事务处理过程中读取了另一个事务中修改并**已提交**的数据

+***

- > 可重复读的意思是不管读几次,结果都一样,可以重复的读,可以理解为快照读,要读的数据集不会发生变化

-* 幻读 (Phantom Reads):在事务中按某个条件先后两次查询数据库,后一次查询查到了前一次查询没有查到的行,**数据条目**发生了变化。比如查询某数据不存在,准备插入此记录,但执行插入时发现此记录已存在,无法插入

-**隔离级别操作语法:**

+##### REPEAT

-* 查询数据库隔离级别

+* repeat 循环标准语法

```mysql

- SELECT @@TX_ISOLATION;

- SHOW VARIABLES LIKE 'tx_isolation';

+ 初始化语句;

+ REPEAT

+ 循环体语句;

+ 条件控制语句;

+ UNTIL 条件判断语句

+ END REPEAT;

```

-* 修改数据库隔离级别

+* 计算 1~10 之间的和

```mysql

- SET GLOBAL TRANSACTION ISOLATION LEVEL 级别字符串;

+ DELIMITER $

+ CREATE PROCEDURE pro_test9()

+ BEGIN

+ -- 定义求和变量

+ DECLARE result INT DEFAULT 0;

+ -- 定义初始化变量

+ DECLARE num INT DEFAULT 1;

+ -- repeat循环

+ REPEAT

+ -- 累加

+ SET result = result + num;

+ -- 让num+1

+ SET num = num + 1;

+ -- 停止循环

+ UNTIL num > 10

+ END REPEAT;

+ -- 查询求和结果

+ SELECT result;

+ END$

+

+ DELIMITER ;

+ -- 调用pro_test9存储过程

+ CALL pro_test9();

```

-***

+***

-### 并发控制

-#### MVCC

+##### LOOP

-MVCC 全称 Multi-Version Concurrency Control,即多版本并发控制,用来**解决读写冲突的无锁并发控制**

+LOOP 实现简单的循环,退出循环的条件需要使用其他的语句定义,通常可以使用 LEAVE 语句实现,如果不加退出循环的语句,那么就变成了死循环

-MVCC 处理读写请求,可以做到在发生读写请求冲突时不用加锁,这个读是指的快照读,而不是当前读

+* loop 循环标准语法

-* 快照读:实现基于 MVCC,因为是多版本并发,所以快照读读到的数据不一定是当前最新的数据,有可能是历史版本的数据

-* 当前读:读取数据库记录是当前最新的版本(产生幻读、不可重复读),可以对读取的数据进行加锁,防止其他事务修改数据,是悲观锁的一种操作,读写操作加共享锁或者排他锁和串行化事务的隔离级别都是当前读

+ ```mysql

+ [循环名称:] LOOP

+ 条件判断语句

+ [LEAVE 循环名称;]

+ 循环体语句;

+ 条件控制语句;

+ END LOOP 循环名称;

+ ```

+

+* 计算 1~10 之间的和

-数据库并发场景:

+ ```mysql

+ DELIMITER $

+ CREATE PROCEDURE pro_test10()

+ BEGIN

+ -- 定义求和变量

+ DECLARE result INT DEFAULT 0;

+ -- 定义初始化变量

+ DECLARE num INT DEFAULT 1;

+ -- loop循环

+ l:LOOP

+ -- 条件成立,停止循环

+ IF num > 10 THEN

+ LEAVE l;

+ END IF;

+ -- 累加

+ SET result = result + num;

+ -- 让num+1

+ SET num = num + 1;

+ END LOOP l;

+ -- 查询求和结果

+ SELECT result;

+ END$

+ DELIMITER ;

+ -- 调用pro_test10存储过程

+ CALL pro_test10();

+ ```

-* 读-读:不存在任何问题,也不需要并发控制

-* 读-写:有线程安全问题,可能会造成事务隔离性问题,可能遇到脏读,幻读,不可重复读

-* 写-写:有线程安全问题,可能会存在丢失更新问题

+***

-MVCC 的优点:

-* 在并发读写数据库时,做到在读操作时不用阻塞写操作,写操作也不用阻塞读操作,提高了并发读写的性能

-* 可以解决脏读,不可重复读等事务隔离问题(加锁也能解决),但不能解决更新丢失问题

-

-提高读写和写写的并发性能:

-

-* MVCC + 悲观锁:MVCC 解决读写冲突,悲观锁解决写写冲突

-* MVCC + 乐观锁:MVCC 解决读写冲突,乐观锁解决写写冲突

+##### 游标

+游标是用来存储查询结果集的数据类型,在存储过程和函数中可以使用光标对结果集进行循环的处理

+* 游标可以遍历返回的多行结果,每次拿到一整行数据

+* 简单来说游标就类似于集合的迭代器遍历

+* MySQL 中的游标只能用在存储过程和函数中

-参考文章:https://www.jianshu.com/p/8845ddca3b23

+游标的语法

+* 创建游标

+ ```mysql

+ DECLARE 游标名称 CURSOR FOR 查询sql语句;

+ ```

-***

+* 打开游标

+ ```mysql

+ OPEN 游标名称;

+ ```

+* 使用游标获取数据

-#### 原理

+ ```mysql

+ FETCH 游标名称 INTO 变量名1,变量名2,...;

+ ```

-##### 隐藏字段

+* 关闭游标

-实现原理主要是隐藏字段,undo日志,Read View 来实现的

+ ```mysql

+ CLOSE 游标名称;

+ ```

-数据库中的每行数据,除了自定义的字段,还有数据库隐式定义的字段:

+* Mysql 通过一个 Error handler 声明来判断指针是否到尾部,并且必须和创建游标的 SQL 语句声明在一起:

-* DB_TRX_ID:6byte,最近修改事务ID,记录创建该数据或最后一次修改(修改/插入)该数据的事务ID。当每个事务开启时,都会被分配一个ID,这个 ID 是递增的

+ ```mysql

+ DECLARE EXIT HANDLER FOR NOT FOUND (do some action,一般是设置标志变量)

+ ```

-* DB_ROLL_PTR:7byte,回滚指针,配合 undo 日志,指向上一个旧版本(存储在 rollback segment)

+

-* DB_ROW_ID:6byte,隐含的自增ID(**隐藏主键**),如果数据表没有主键,InnoDB 会自动以 DB_ROW_ID 作为聚簇索引

+游标的基本使用

-* DELETED_BIT:删除标志的隐藏字段,记录被更新或删除并不代表真的删除,而是删除位变了

+* 数据准备:表 student

-

+ ```mysql

+ id NAME age gender score

+ 1 张三 23 男 95

+ 2 李四 24 男 98

+ 3 王五 25 女 100

+ 4 赵六 26 女 90

+ ```

+* 创建 stu_score 表

+ ```mysql

+ CREATE TABLE stu_score(

+ id INT PRIMARY KEY AUTO_INCREMENT,

+ score INT

+ );

+ ```

+* 将student表中所有的成绩保存到stu_score表中

+ ```mysql

+ DELIMITER $

+

+ CREATE PROCEDURE pro_test12()

+ BEGIN

+ -- 定义成绩变量

+ DECLARE s_score INT;

+ -- 定义标记变量

+ DECLARE flag INT DEFAULT 0;

+

+ -- 创建游标,查询所有学生成绩数据

+ DECLARE stu_result CURSOR FOR SELECT score FROM student;

+ -- 游标结束后,将标记变量改为1 这两个必须声明在一起

+ DECLARE EXIT HANDLER FOR NOT FOUND SET flag = 1;

+

+ -- 开启游标

+ OPEN stu_result;

+ -- 循环使用游标

+ REPEAT

+ -- 使用游标,遍历结果,拿到数据

+ FETCH stu_result INTO s_score;

+ -- 将数据保存到stu_score表中

+ INSERT INTO stu_score VALUES (NULL,s_score);

+ UNTIL flag=1

+ END REPEAT;

+ -- 关闭游标

+ CLOSE stu_result;

+ END$

+

+ DELIMITER ;

+

+ -- 调用pro_test12存储过程

+ CALL pro_test12();

+ -- 查询stu_score表

+ SELECT * FROM stu_score;

+ ```

+

+

@@ -2802,34 +3293,59 @@ MVCC 的优点:

-##### undo

+#### 存储函数

-undo log 是逻辑日志,记录的是每个事务对数据执行的操作,而不是记录的全部数据,需要根据 undo log 逆推出以往事务的数据

+存储函数和存储过程是非常相似的,存储函数可以做的事情,存储过程也可以做到

-undo log 的作用:

+存储函数有返回值,存储过程没有返回值(参数的 out 其实也相当于是返回数据了)

-* 保证事务进行 rollback 时的原子性和一致性,当事务进行回滚的时候可以用 undo log 的数据进行恢复

-* 用于 MVCC 快照读,通过读取 undo log 的历史版本数据可以实现不同事务版本号都拥有自己独立的快照数据版本

+* 创建存储函数

-undo log 主要分为两种:

+ ```mysql

+ DELIMITER $

+ -- 标准语法

+ CREATE FUNCTION 函数名称(参数 数据类型)

+ RETURNS 返回值类型

+ BEGIN

+ 执行的sql语句;

+ RETURN 结果;

+ END$

+

+ DELIMITER ;

+ ```

-* insert undo log:事务在 insert 新记录时产生的 undo log,只在事务回滚时需要,并且在事务提交后可以被立即丢弃

+* 调用存储函数,因为有返回值,所以使用 SELECT 调用

-* update undo log:事务在进行 update 或 delete 时产生的 undo log,在事务回滚时需要,在快照读时也需要。不能随意删除,只有在快速读或事务回滚不涉及该日志时,对应的日志才会被 purge 线程统一清除

+ ```mysql

+ SELECT 函数名称(实际参数);

+ ```

-每次对数据库记录进行改动,都会将旧值放到一条 undo 日志中,算是该记录的一个旧版本,随着更新次数的增多,所有的版本都会被 roll_pointer 属性连接成一个链表,把这个链表称之为**版本链**,版本链的头节点就是当前记录最新的值,链尾就是最早的旧记录

+* 删除存储函数

- + ```mysql

+ DROP FUNCTION 函数名称;

+ ```

-* 有个事务插入 persion 表一条新记录,name 为 Jerry,age 为 24

+* 定义存储函数,获取学生表中成绩大于95分的学生数量

-* 事务 1 修改该行数据时,数据库会先对该行加排他锁,然后先记录 undo log,然后修改该行 name 为 Tom,并且修改隐藏字段的事务 ID 为当前事务 1 的 ID(默认为 1 之后递增),回滚指针指向拷贝到 undo log 的副本记录,事务提交后,释放锁

-* 以此类推

+ ```mysql

+ DELIMITER $

+ CREATE FUNCTION fun_test()

+ RETURN INT

+ BEGIN

+ -- 定义统计变量

+ DECLARE result INT;

+ -- 查询成绩大于95分的学生数量,给统计变量赋值

+ SELECT COUNT(score) INTO result FROM student WHERE score > 95;

+ -- 返回统计结果

+ SELECT result;

+ END

+ DELIMITER ;

+ -- 调用fun_test存储函数

+ SELECT fun_test();

+ ```

-补充知识:purge 线程

-* 为了实现 InnoDB 的 MVCC 机制,更新或者删除操作都只是设置一下老记录的 deleted_bit,并不真正将过时的记录删除,为了节省磁盘空间,InnoDB 有专门的 purge 线程来清理 deleted_bit 为 true 的记录

-* purge 线程维护了一个 Read view(这个 Read view 相当于系统中最老活跃事务的 Read view),如果某个记录的 deleted_bit 为 true,并且 DB_TRX_ID 相对于 purge 线程的 Read view 可见,那么这条记录一定是可以被安全清除的

@@ -2837,30 +3353,22 @@ undo log 主要分为两种:

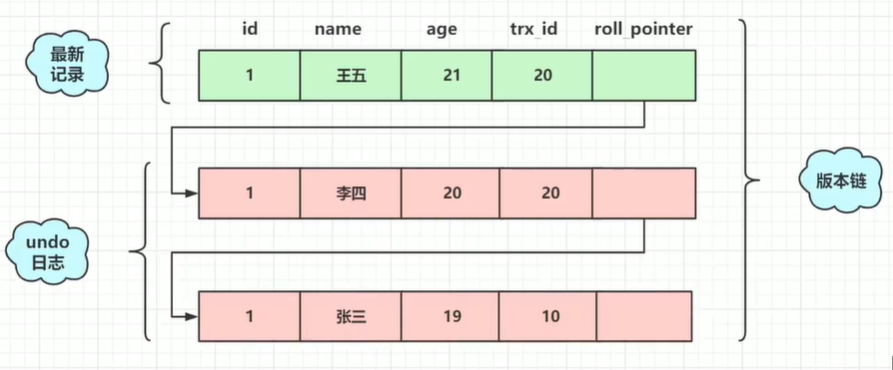

-##### 读视图

-

-Read View 是事务进行**快照读**操作时产生的读视图,该事务执行快照读的那一刻会生成数据库系统当前的一个快照,记录并维护系统当前活跃事务的 ID,用来做可见性判断,根据视图判断当前事务能够看到哪个版本的数据

-

-注意:这里的快照并不是把所有的数据拷贝一份副本,而是由 undo log 记录的逻辑日志,根据库中的数据进行计算出历史数据

-

-工作流程:将版本链的头节点的事务 ID(最新数据事务 ID)DB_TRX_ID 取出来,与系统当前活跃事务的 ID 对比,如果 DB_TRX_ID 不符合可见性,通过 DB_ROLL_PTR 回滚指针去取出 undo log 中的下一个 DB_TRX_ID 比较,直到找到最近的满足特定条件的 DB_TRX_ID,该事务 ID 所在的旧记录就是当前事务能看见的最新的记录

+### 触发器

-Read View 几个属性:

+#### 基本介绍

-- m_ids:生成 Read View 时当前系统中活跃的事务 id 列表(未提交的事务集合,当前事务也在其中)

-- up_limit_id:生成 Read View 时当前系统中活跃的最小的事务 id,也就是 m_ids 中的最小值(已提交的事务集合)

-- low_limit_id:生成 Read View 时系统应该分配给下一个事务的 id 值,m_ids 中的最大值加 1(未开始事务)

-- creator_trx_id:生成该 Read View 的事务的事务 id,就是判断该 id 的事务能读到什么数据

+触发器是与表有关的数据库对象,在 insert/update/delete 之前或之后触发并执行触发器中定义的 SQL 语句

-creator 创建一个 Read View,进行可见性算法分析:(解决了读未提交)

+* 触发器的这种特性可以协助应用在数据库端确保数据的完整性 、日志记录 、数据校验等操作

-* db_trx_id == creator_trx_id:表示这个数据就是当前事务自己生成的,自己生成的数据自己肯定能看见,所以这种情况下此数据对 creator 是可见的

-* db_trx_id < up_limit_id:该版本对应的事务 ID 小于 Read view 中的最小活跃事务 ID,则这个事务在当前事务之前就已经被提交了,对 creator 可见

+- 使用别名 NEW 和 OLD 来引用触发器中发生变化的记录内容,这与其他的数据库是相似的

+- 现在触发器还只支持行级触发,不支持语句级触发

-* db_trx_id >= low_limit_id:该版本对应的事务 ID 大于 Read view 中当前系统的最大事务 ID,则说明该数据是在当前 Read view 创建之后才产生的,对 creator 不可见

-* up_limit_id <= db_trx_id < low_limit_id:判断 db_trx_id 是否在活跃事务列表 m_ids 中

- * 在列表中,说明该版本对应的事务正在运行,数据不能显示(**不能读到未提交的数据**)

- * 不在列表中,说明该版本对应的事务已经被提交,数据可以显示(**可以读到已经提交的数据**)

+| 触发器类型 | OLD的含义 | NEW的含义 |

+| --------------- | ------------------------------ | ------------------------------ |

+| INSERT 型触发器 | 无 (因为插入前状态无数据) | NEW 表示将要或者已经新增的数据 |

+| UPDATE 型触发器 | OLD 表示修改之前的数据 | NEW 表示将要或已经修改后的数据 |

+| DELETE 型触发器 | OLD 表示将要或者已经删除的数据 | 无 (因为删除后状态无数据) |

@@ -2868,245 +3376,317 @@ creator 创建一个 Read View,进行可见性算法分析:(解决了读

-##### 工作流程

-

-表 user 数据

-

-```sh

-id name age

-1 张三 18

-```

-

-Transaction 20:

-

-```mysql

-START TRANSACTION; -- 开启事务

-UPDATE user SET name = '李四' WHERE id = 1;

-UPDATE user SET name = '王五' WHERE id = 1;

-```

-

-Transaction 60:

-

-```mysql

-START TRANSACTION; -- 开启事务

--- 操作表的其他数据

-```

-

-

-

-ID 为 0 的事务创建 Read View:

-

-* m_ids:20、60

-* up_limit_id:20

-* low_limit_id:61

-* creator_trx_id:0

+#### 基本操作

-

+* 创建触发器

-只有红框部分才复合条件,所以只有张三对应的版本的数据可以被看到

+ ```mysql

+ DELIMITER $

+

+ CREATE TRIGGER 触发器名称

+ BEFORE|AFTER INSERT|UPDATE|DELETE

+ ON 表名

+ [FOR EACH ROW] -- 行级触发器

+ BEGIN

+ 触发器要执行的功能;

+ END$

+

+ DELIMITER ;

+ ```

+* 查看触发器的状态、语法等信息

+ ```mysql

+ SHOW TRIGGERS;

+ ```

-参考视频:https://www.bilibili.com/video/BV1t5411u7Fg

+* 删除触发器,如果没有指定 schema_name,默认为当前数据库

+ ```mysql

+ DROP TRIGGER [schema_name.]trigger_name;

+ ```

+

***

-#### RC RR

+#### 触发演示

-Read View 用于支持 RC(Read Committed,读已提交)和 RR(Repeatable Read,可重复读)隔离级别的实现

+通过触发器记录账户表的数据变更日志。包含:增加、修改、删除

-RR、RC 生成时机:

+* 数据准备

-- RC 隔离级别下,每个快照读都会生成并获取最新的 Read View

-- RR 隔离级别下,则是同一个事务中的第一个快照读才会创建 Read View

+ ```mysql

+ -- 创建db9数据库

+ CREATE DATABASE db9;

+ -- 使用db9数据库

+ USE db9;

+ ```

-RC、RR 级别下的 InnoDB 快照读区别

+ ```mysql

+ -- 创建账户表account

+ CREATE TABLE account(

+ id INT PRIMARY KEY AUTO_INCREMENT, -- 账户id

+ NAME VARCHAR(20), -- 姓名

+ money DOUBLE -- 余额

+ );

+ -- 添加数据

+ INSERT INTO account VALUES (NULL,'张三',1000),(NULL,'李四',2000);

+ ```

-- RC 级别下的,事务中每次快照读都会新生成一个 Read View,这就是在 RC 级别下的事务中可以看到别的事务提交的更新的原因

+ ```mysql

+ -- 创建日志表account_log

+ CREATE TABLE account_log(

+ id INT PRIMARY KEY AUTO_INCREMENT, -- 日志id

+ operation VARCHAR(20), -- 操作类型 (insert update delete)

+ operation_time DATETIME, -- 操作时间

+ operation_id INT, -- 操作表的id

+ operation_params VARCHAR(200) -- 操作参数

+ );